Die Dimensionen des Google-Rankings 9 Nov 2024 11:08 PM (5 months ago)

Die Rankingfaktoren bei Google sind über die Jahre immer mehrdimensionaler und vielfältiger geworden, was die die Suchmaschinenoptimierung immer komplexer erscheinen lässt. In diesem Artikel geht es um die Entwicklung der Ranking-Faktoren in der Suchmaschinenoptimierung (SEO) von der Dokumenten-Ebene hin zu Domain- und Urheber-Entitäten-Ebene. Zudem werden die drei Bewertungs-Dimensionen für das Google-Ranking erklärt und welche Ranking-Faktoren auf den Dokumenten-, Domain- und Urheber-Entitäten-Ebenen wirken.

Immer mehr Rankingfaktoren auf Meta-Ebene

Suchmaschinenoptimierung bestand früher in erster Linie aus der Optimierung einzelner Dokumente. Der Fokus von SEO lag lange Zeit auf der Dokumentenebene. Im Jahr 2009 begann Google mit dem Vince Update, auch Brand Update genannt, immer mehr Domain- bzw. sitewide Faktoren einzuführen.

- 2009: Vince Update (Brand Update): Bekannte Brand-Domains bekommen Rankingvorteile

- 2011: Panda Update: Content-Qualität als sitewide Faktor

- 2012: Google Exact Match Domain (EMD) Update

- 2014: Vorstellung von E-A-T in den Quality Rater Guidelines. Sitewide Content-Qualität zu Themen und Trust der Urheber (Publisher/Autor)

- 2021: Page Experience System: Die Page Experience ganzer Websitebereiche fließt in das Ranking mit ein.

- 2022: Helpful Content System: Bewertung von Content-Qualität über sitewide Qualifier

- 2018 bis heute: Diverse Core Updates: U.a. mit Schwerpunkt E-E-A-T

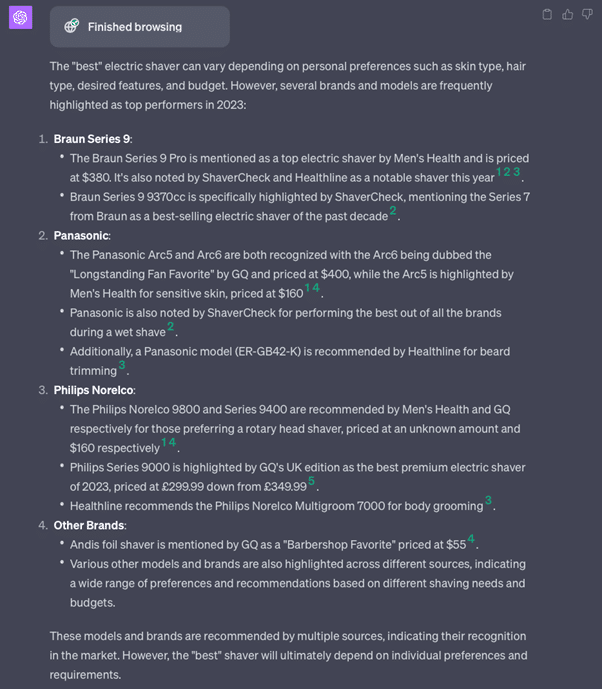

Dokumenten Relevanz Scoring vs. Entitäten- bzw. Domain-Qualitäts-Bewertung

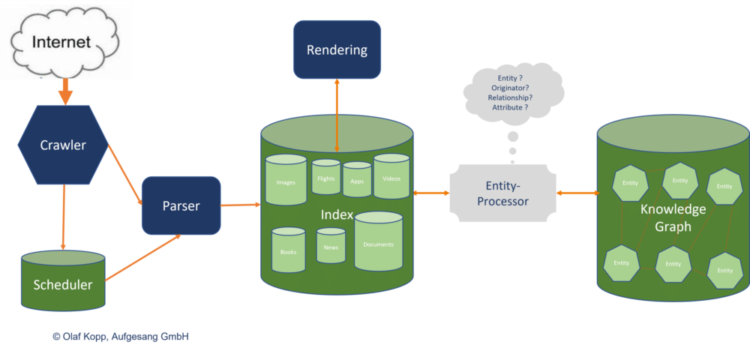

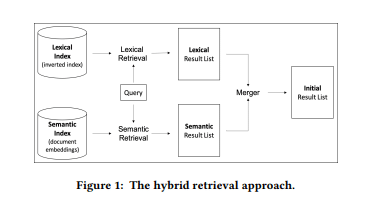

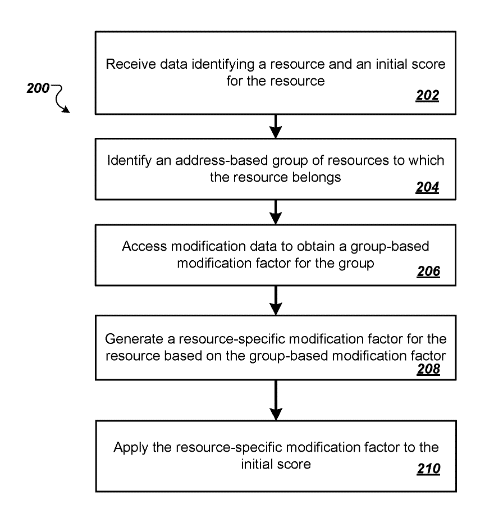

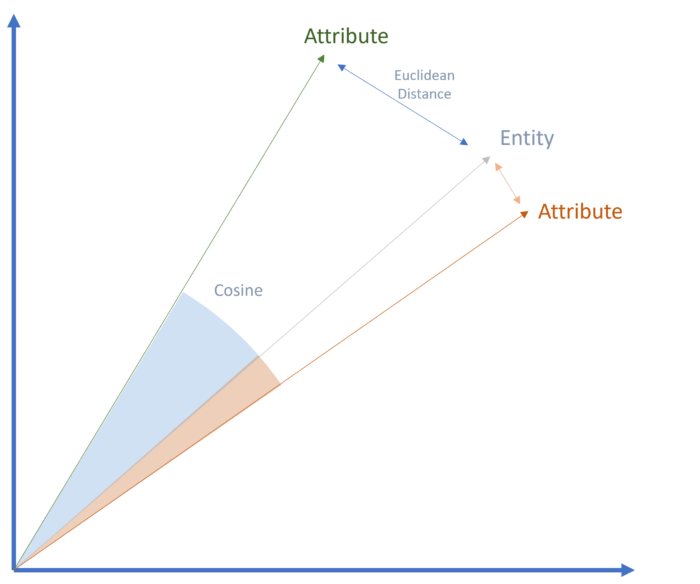

Im Information-Retrieval-Prozess muss zwischen dem Scoring auf Dokumenten-Ebene und Bewertung der Domain, Website-Bereich, Thema oder Urheber-Entität unterschieden werden.

Das Scoring auf Dokumentenebene orientiert sich in erster Linie an der Suchanfrage und deren Suchintention und bewertet die Relevanz eines Inhalts zur Suchanfrage.

Bewertungen auf einer Meta-Ebene Suchanfragen-unabhängig sind. Sie bewerten die Qualität der Quelle generell oder bezogen auf ein Thema.

Mehr dazu im Beitrag Relevanz, Pertinenz und Qualität bei Suchmaschinen

Die Bedeutung des Ursprungs eines Inhalts wächst

Schon lange vor (E-)E-A-T hat Google versucht, die Bewertung der Quelle eines Inhalts in das Ranking mit einzubeziehen. Zu nennen ist z.B. das Vince-Update aus dem Jahr 2009, bei dem die Inhalte von Brands im Ranking bevorteilt wurden.

Über bereits lange beendete Projekte wie Knol oder Google+ hat Google versucht, Signale für eine Autoren-Bewertung über z.B. einen Social Graph und Nutzer-Bewertungen zu sammeln.

So findet man in den letzten 20 Jahren einige Google-Patente, die auf Content-Plattformen wie Knol oder soziale Netzwerke wie Google+ direkt oder indirekt verweisen. Auf einige werde ich im Verlauf des Artikels eingehen.

Den Ursprung bzw. den Autoren eines Inhalts nach den Kriterien von E-E-A-T zu bewerten, ist ein wichtiger Schritt und eine fundamentale Weiterentwicklung beim Ranking von Suchergebnissen.

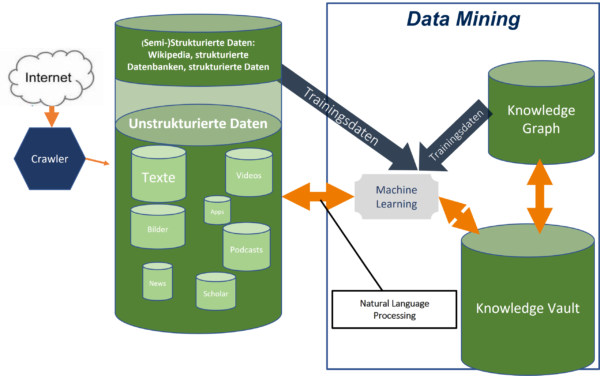

Auch mit Blick auf die Fülle an KI-generiertem Content, aber auch klassischem Spam ist es ein wichtiger Schritt. Es macht für Google keinen Sinn, minderwertige Inhalte in den Suchindex zu übernehmen. Je mehr Inhalte Google indexiert und im Information-Retrieval-Prozess verarbeiten muss, desto mehr Rechenleistung wird benötigt.

E-E-A-T kann Google helfen, basierend auf Entitäten bzw. Domain- und Autoren-Ebene im Big Scale zu bewerten, ohne jeden einzelnen Inhalt crawlen zu müssen. Auf dieser Makro-Ebene lassen sich Inhalte gemäß der Urheber-Entität klassifizieren und mit mehr oder weniger Crawlingbudget ausstatten. Zudem kann Google über diesen Weg ganze Inhaltsgruppen von der Indexierung ausschließen.

Die drei Bewertungs-Dimensionen für das Google-Ranking

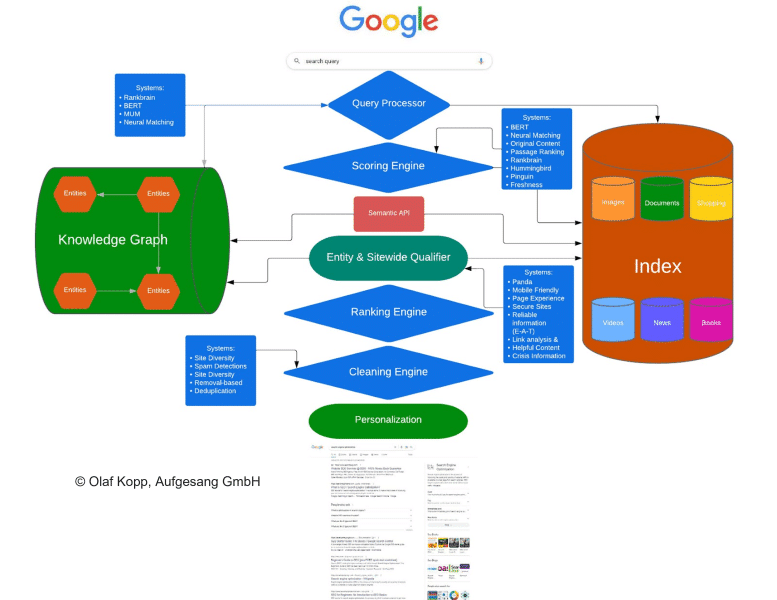

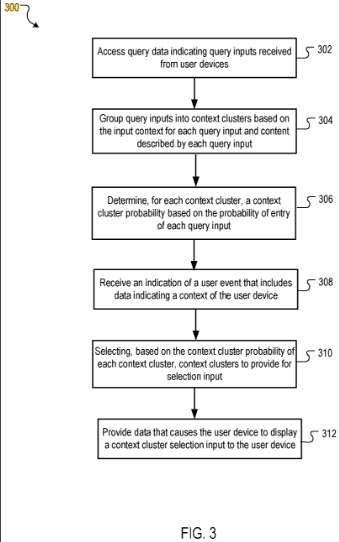

Für SEO ist es wichtig zu verstehen auf welchen Ebenen nach welchen Rankingfaktoren die Suchergebnisse ermittelt werden. Deswegen nachfolgend eine kurze Erläuterung der drei Dimensionen.

Zu unterscheiden ist nach Dokumentenspezifischen Rankingfaktoren und generelleren Meta-Faktoren.

Dokumenten-Level

Rankingfaktoren, die für die Bewertung der Relevanz verantwortlich sind. wirken in der Regel auf Dokumentenebene. Relevant ist etwas für Suchmaschinen wenn ein Dokument bzw. Inhalt in Bezug auf die Suchanfrage und deren Suchintention bedeutsam ist.

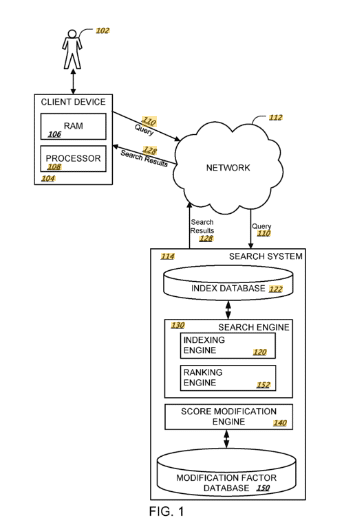

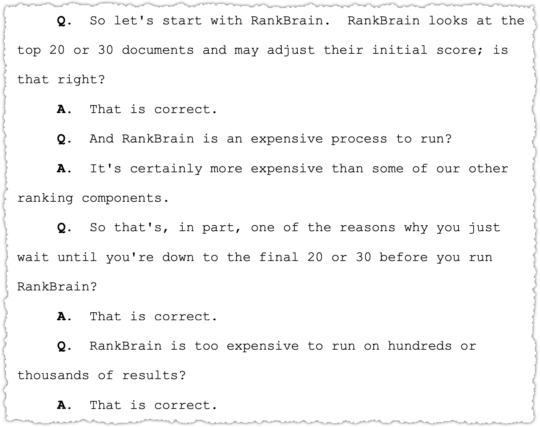

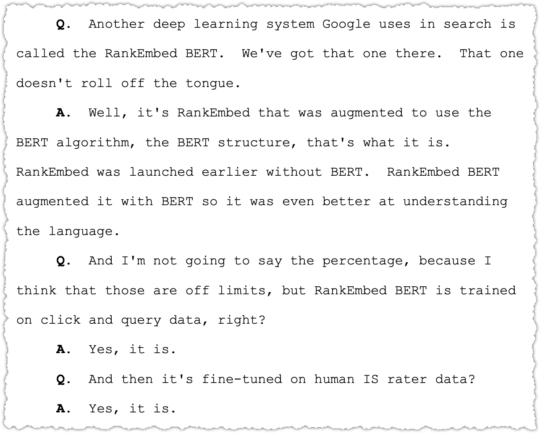

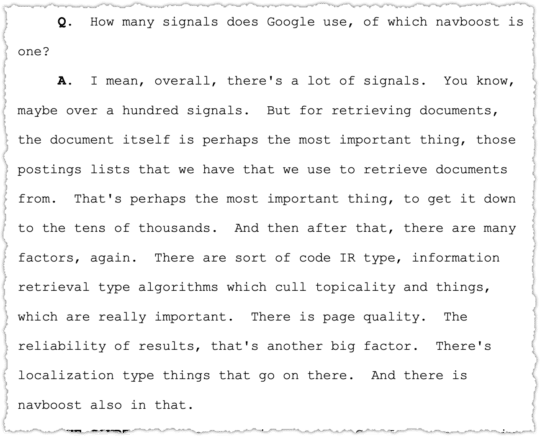

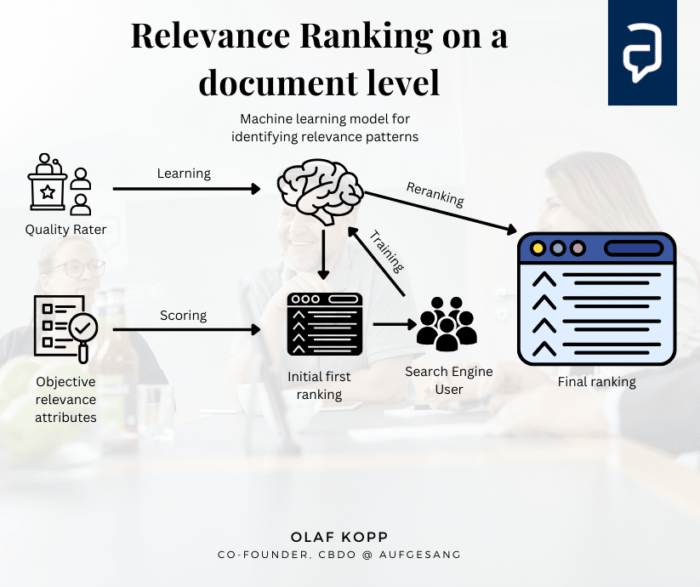

Die Relevanzbewertung auf Dokumentenebene findet durch den Ascorer / Muppet für das initiale Ranking und Superroot / Twiddler für das fortlaufende Reranking statt.

Hier einige der Rankingfaktoren, die auf Dokumentenebene angewandt werden:

- Keyword-Nutzung in Überschriften, Content und Seitentitel

- TF-IDF / BM25

- Interne und externe Verlinkung und Ankertexte

- Treffen der Suchintention

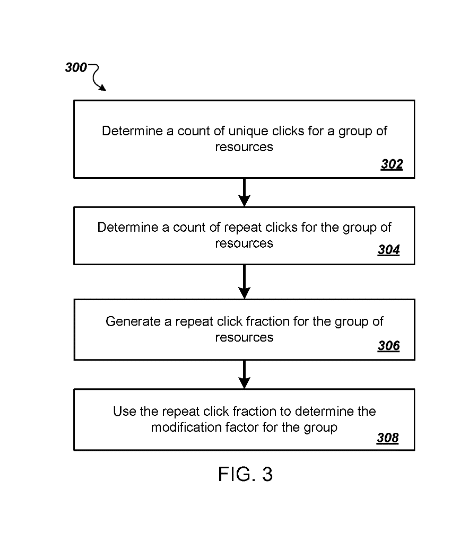

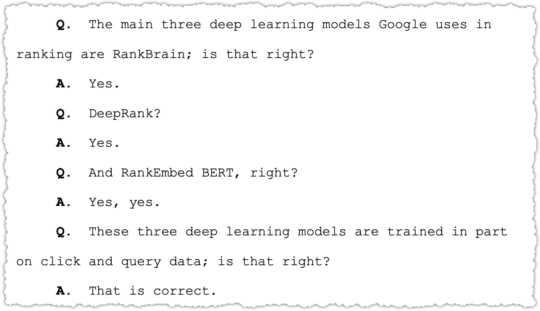

- Nutzersignale (Deeprank, RankEmbed BERT, Navboost)

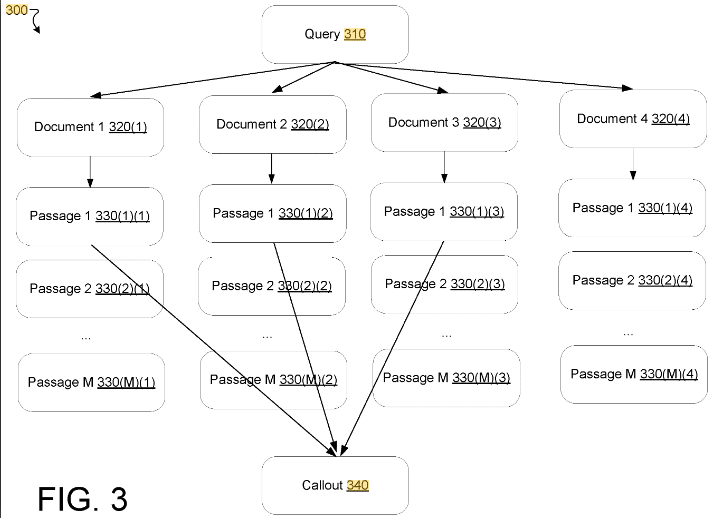

- Passage Based Indexing

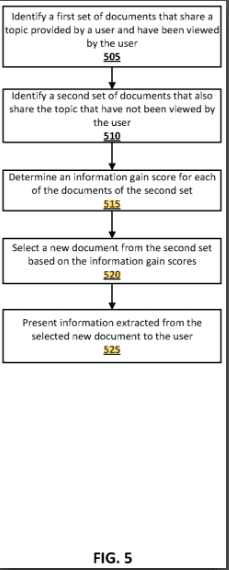

- Information Gain

- Helpful Content (E-E-A-T)

- Knowledge Based Trust (E-E-A-T)

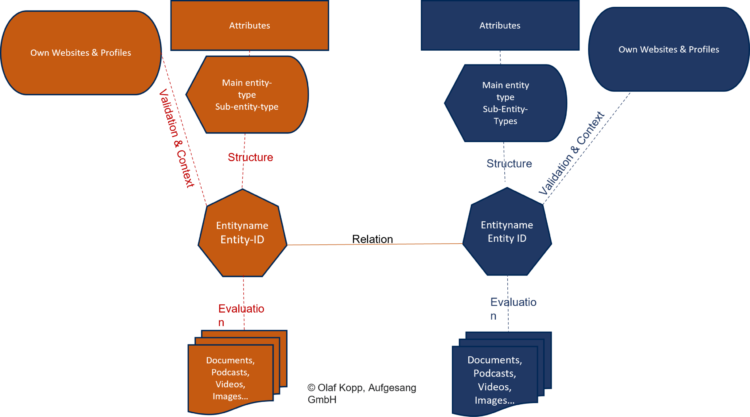

Domain-Level

Domains sind digitale Repräsentanzen von Urheber-Entitäten. Auf Domain-Ebene gelten, aber auch Entitäten-unabhängige Rankingfaktoren. Von daher sollte man diese Dimension segmentiert betrachten. Sitewide- oder Domain-bezogene Rankingfaktoren können sowohl auf Gesamtdomain-Ebene, Website-Bereich-Ebene oder Themen-Ebene wirken und sind keine Relevanz- sondern Qualitätsfaktoren. Hier einige Rankingfaktoren auf Domain-Level:

- Top Level Domains (TLDs)

- Interne und externe Verlinkung und Ankertexte

- Content-Qualität im Gesamten oder pro Thema (E-E-A-T)

- Page Experience (Core Web Vitals)

- Domain-Alter

- Domain-Trust

- Entfernung zu Trust Seed Sites im Linkgraph (E-E-A-T)

- Transparenz zu den Autoren und Publisher (E-E-A-T)

- Topical Authority (E-E-A-T)

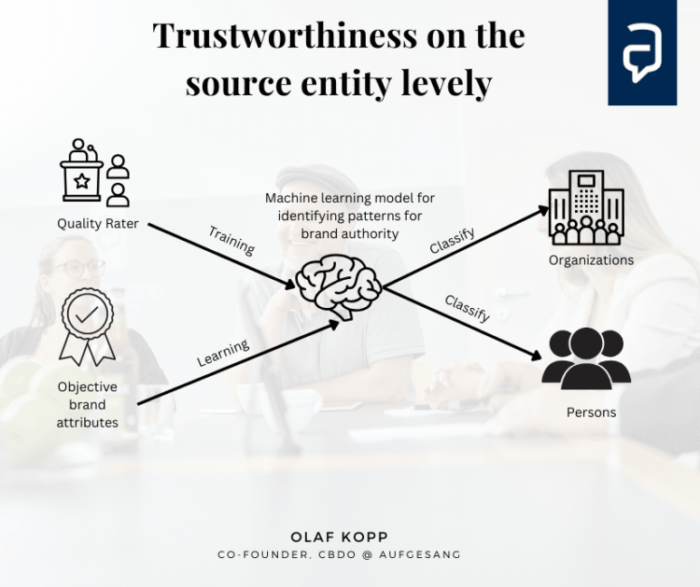

Urheber-Entitäten-Level

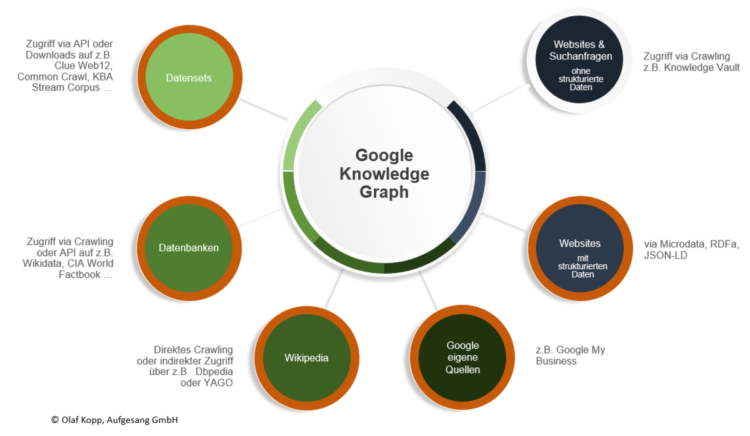

Die Bewertung von Urheber-Entitäten (Autoren, Organisationen) gemäß E-E-A-T ist ein relativ neue Dimension beim Google-Ranking. Es ist auch eine thematische oder generelle Qualitäts-Bewertung, die auch Domain unabhängig angewendet werden kann. Die Grundlage wurde 2013 durch das Hummingbird Update und den Knowledge Graph geschaffen. Mehr dazu findest du hier im Blog oder wenn du nach Olaf Kopp E-E-A-T googlest.

Rankingfaktoren zur Bewertung der Urheber-Entität sind u.a.

- Erfahrung des Autors

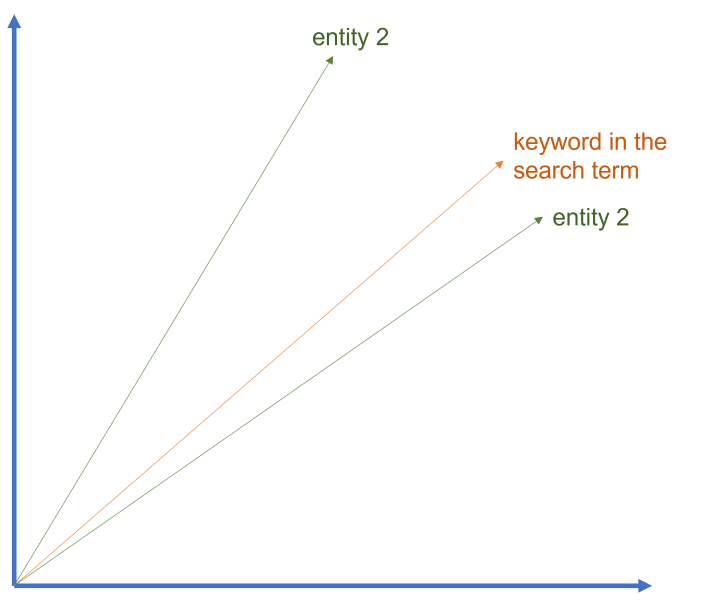

- Kookkurrenzen des Entitätsnamens mit thematisch relevanten Begriffen in Suchanfragen und Inhalten

- Sentiment um die Entität

- Anzahl an veröffentlichten Inhalten zu einem Thema

- Anteil an Inhalten innerhalb eines thematischen Dokumenten-Korpus

- Nennung der Entität in Best of und Award-Listen

- Brand Suchvolumen

Zusammenfassung

In der Suchmaschinenoptimierung ist es wichtig, zwischen dem Scoring auf Dokumentenebene und der Bewertung von Domain, Website-Bereich, Thema oder Urheber-Entität zu unterscheiden. Das Scoring auf Dokumentenebene bezieht sich auf die Suchanfrage und bewertet die Relevanz eines Inhalts zur Suchanfrage. Bewertungen auf einer Meta-Ebene sind unabhängig von der Suchanfrage und bewerten die Qualität der Quelle generell oder bezogen auf ein Thema.

Die Bewertung der Quelle eines Inhalts ist für Google schon lange ein wichtiger Ranking-Faktor. Mit E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) bewertet Google die Urheber-Entität eines Inhalts und ermöglicht es, Inhalte gemäß der Urheber-Entität zu klassifizieren und zu bewerten. Dies ist insbesondere wichtig angesichts der Fülle an KI-generiertem Content und klassischem Spam.

Es gibt drei Dimensionen, nach denen die Suchergebnisse ermittelt werden: Dokumenten-Level, Domain-Level und Urheber-Entitäten-Level. Dokumenten-Level bezieht sich auf die Bewertung der Relevanz eines Inhalts, Domain-Level auf die Bewertung von Qualitätsfaktoren und Urheber-Entitäten-Level auf die Bewertung der Urheber-Entität selbst. Es ist wichtig zu verstehen, auf welchen Ebenen nach welchen Rankingfaktoren die Suchergebnisse ermittelt werden.

Mehr dazu wie die Google-Suche heute funktionier in diesem Deep Dive

Der Beitrag Die Dimensionen des Google-Rankings erschien zuerst auf Aufgesang.

80+ Faktoren für eine E-E-A-T-Bewertung durch Google 5 Nov 2024 3:35 AM (5 months ago)

Im Jahr 2022 veröffentlichte ich erstmals eine Übersicht über E-E-A-T-Signale, die Google messen kann, um E-E-A-T für Domains, Unternehmen und Autoren zu bewerten. Ich hatte alle Signale aus verschiedenen Google-Quellen und Patenten recherchiert. Der Beitrag war der zweitbeliebteste Artikel von Search Engine Land im Jahr 2022.

Seitdem bin ich auf viele weitere Google-Patente gestoßen, die Hinweise auf andere mögliche E-E-A-T-Signale liefern. Deshalb ist es Zeit für ein Update. Ich konnte über 80 mögliche Signale aus mehr als 40 Quellen ermitteln. Alle Patente, auf die ich mich beziehe, befinden sich in der Datenbank meiner SEO Resesarch Suite.

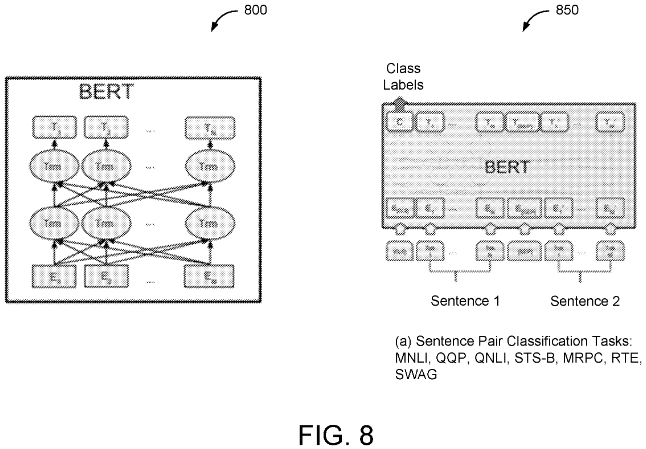

Ich höre immer wieder, dass SEOs nicht glauben, dass E-E-A-T einen Einfluss auf das Ranking hat, und denken, dass es nur ein Modewort ist. Man muss verstehen, dass Google gerne PR-Claims wie „Hilfreicher Inhalt“ oder „E-E-A-T“ verwendet, um das Suchprodukt mit aussagekräftigen positiven Attributen zu versehen. Diese Namen sind nur eine Klammer oder eine Sammlung für viele einzelne Signale und Algorithmen, die unabhängig voneinander arbeiten.

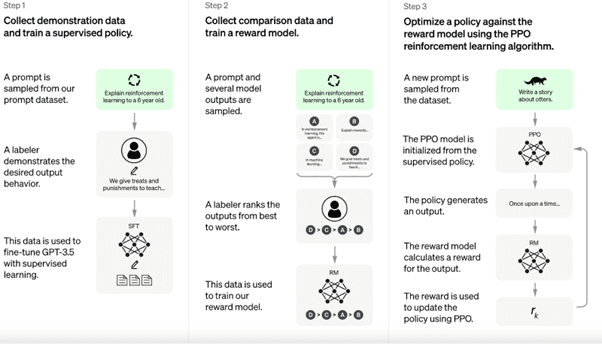

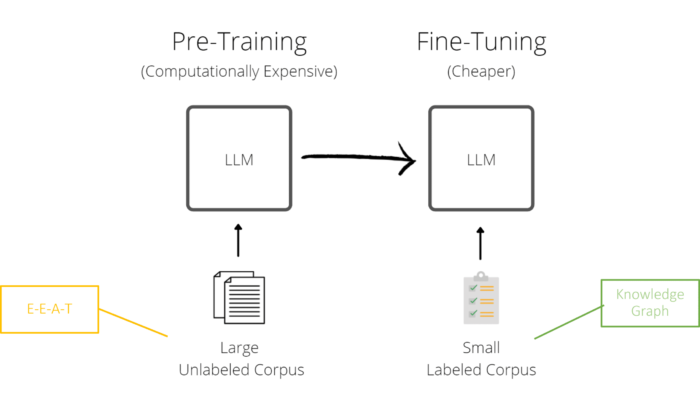

Google muss Signale identifizieren und messen, um das E-E-A-T-Puzzle zusammenzusetzen und algorithmisch vertrauenswürdigere Ressourcen in den SERPs zu erreichen, um diese Qualitätsbewertung zu skalieren. Diese Qualitätsbewertung könnte auch eine wichtige Rolle bei der Auswahl von Ressourcen für die Schulung von LLMs spielen. Daher ist diese Forschung so wichtig für die Erweiterung des Wissens und die Grundlage für die Optimierung von E-E-A-T.

Weder in Google-Patenten noch im API-Leak oder in den Dokumenten des DOJ wird E-E-A-T ausdrücklich erwähnt. Bei meiner Recherche habe ich mich darauf konzentriert, Quellen zu finden, in denen Qualität, Vertrauen, Autorität und Fachwissen erwähnt werden.

Mehr über E-E-A-T erfahren Sie in meinem umfassenden Leitfaden.

Disclaimer:

Diese Zusammenfassung möglicher E-E-A-T-Faktoren, die Google als Signale für E-E-A-T heranziehen kann ist nicht als Tipp-Liste für SEOs zu verstehen, die diese manipulieren wollen. Die Beeinflussung von E-E-A-T ist nur bedingt durch SEO-Maßnahmen zu beeinflussen, da die aufgeführten Signale eher durch Marketing und PR zu beeinflussen sind. Vorab möchte ich klarstellen, dass die nachfolgend aufgeführten Faktoren für eine E-E-A-T-Bewertung großteils nicht durch Google bestätigt sind. Aber sie sind auch mehr als eine Meinung, da ich sie aus verschiedenen Google Patenten, Whitepapern und wissenschaftlichen Papieren aus de Hause Google recherchiert habe. Von daher ist es fundierter als vieles von dem was man in der Branche hört und liest. Die Quellen habe ich zu jedem Faktor angegeben, sodass Du Dich selbst tiefer einlesen kannst, wenn du magst.

Es gibt keinen einzigen zusammengefassten E-E-A-T-Score

Laut Google gibt es keinen einzelnen E-E-A-T-Score in den alle Signale zusammengefasst bzw. aufgerechnet werden. Ich kann mir vorstellen, dass Google durch viele verschiedene Algorithmen ein Gesamteindruck von E-E-A-T eines Autors, Publishers bzw. Website erhält. Dieser Gesamteindruck ist weniger als Score zu verstehen, sondern als Annäherung an Musterbild für eine Entität, die über E-E-A-T verfügt. Google könnte anhand von ausgewählten Muster-Entitäten die Algorithmen so trainieren, dass ein Benchmark-Muster für E-E-A-T entsteht. Je mehr die Entität sich über verschiedene Signale mit diesem Musterbild gleicht, desto höher die Qualität. Mehr dazu in den von mir bereits erwähnten weiterführenden Beiträgen.

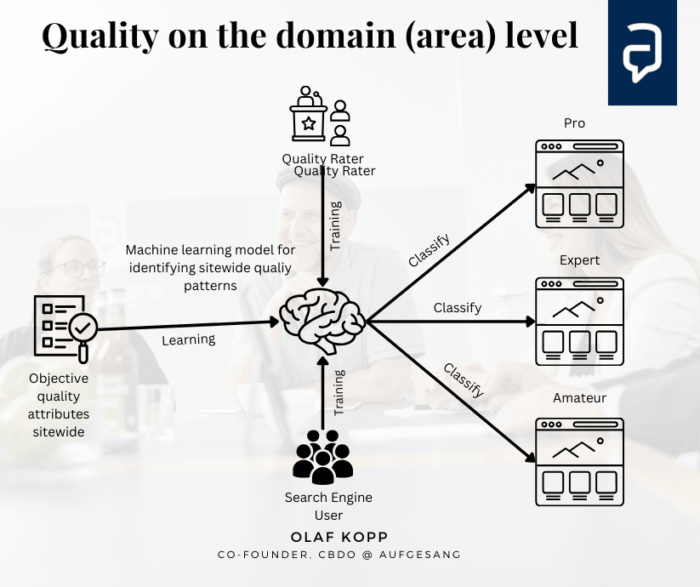

Ranking-Dimensionen bei Google

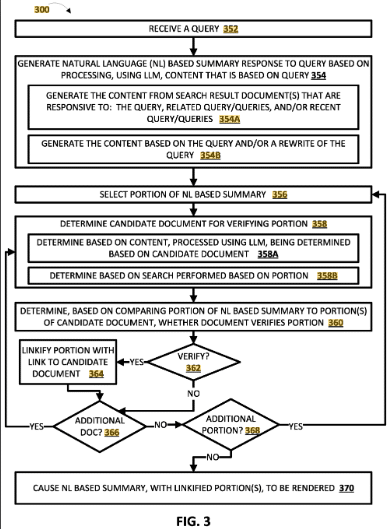

Um die über 80 Signale klar zu strukturieren, habe ich beschlossen, die Signale in die von mir entwickelten Ranking-Dimensionen zu unterteilen:

- Document-Level

- Domain-Level

- Source Entity Level

Die Dimensionen der Google-Rankings haben sich im Laufe der Jahre zu einem komplexen und vielschichtigen System entwickelt. Früher konzentrierte sich die Suchmaschinenoptimierung hauptsächlich auf die Optimierung einzelner Dokumente.

In den letzten 15 Jahren hat Google zunehmend domain- und seitenweite Faktoren eingeführt.

Heute gibt es drei Bewertungsebenen: die Dokumentebene, die Domainebene und die Quellenebene. Relevanzbasierte Faktoren wie die Verwendung von Schlüsselwörtern und die Qualität der Inhalte werden auf Dokumentebene bewertet.

Auf der Domain-Ebene werden seitenweite Qualitätsfaktoren wie Linkprofil und E-E-A-T berücksichtigt.

Auf der Quellenebene wird die Qualität der Autoreneinheit anhand der E-E-A-T-Kriterien bewertet.

Diese mehrdimensionale Bewertung ermöglicht es Google, Inhalte umfassender zu klassifizieren und qualitativ hochwertige Suchergebnisse zu liefern.

Die in diesem Artikel behandelten Signale können in einen oder mehrere Qualitätsklassifikatoren integriert werden.

Klassifikatoren führen keine Bewertung durch und vergeben keine Punkte, sondern klassifizieren Quellentitäten, Domains und Dokumente in verschiedene Klassen wie Spam, schlecht, mittel oder gut. Wie Google bestätigt, gibt es also keine E-E-A-T-Bewertungen, sondern nur Klassen.

Überblick: Signale für eine E-E-A-T-Bewertung basierend auf Grundlagenforschung

Ich habe die folgenden über 80 E-E-A-T-Signale aus 47 Google-Patenten, dem Whitepaper „How Google fights Spam“ und den Quality Rater Guidelines sowie anderen Google-Aussagen recherchiert und zusammengestellt. Unterstützt wurde ich dabei vom AI Patent & Paper Analyzer aus der SEO Research Suite.

E-E-A-T auf Dokumentenebene (Bewertung der Dokumentqualität)

Fachwissen und Erfahrung:

-

- Originalität des Inhalts: Hoher Anteil an Originalinhalten im Vergleich zu kopierten Inhalten.

- Umfassende Themenabdeckung: Erfüllt sowohl Informations- als auch Navigationsabsichten.

- Relevanz für alternative Abfragen: Die Fähigkeit von Inhalten, sowohl für Erst- als auch für alternative Abfragen gerankt zu werden, kann auf Fachwissen und Autorität zu einem Thema hinweisen.

- Relevanz des Ankertextes: Kontextrelevanter Ankertext signalisiert Fachwissen.

- Grammatik und Layoutqualität: Saubere, professionelle Präsentation der Inhalte.

- Länge der Inhalte: Ausführliche Ressourcen, die Themen umfassend abdecken.

- Häufigkeit der Aktualisierungen: Regelmäßig aktualisierte Inhalte, um Relevanz und Genauigkeit zu gewährleisten.

- Vielfalt der Inhaltstypen (Text, Video, Bilder), die unterschiedliche Nutzerpräferenzen und Interaktionsmuster abdecken.

- Grammatik und Layoutqualität – Bewertung von Faktoren wie Grammatik und Layout, die auf Fachwissen und Professionalität hinweisen können.

- Zitate und externe ausgehende Links zu verlässlichen Quellen: Die Anzahl und Qualität der ausgehenden Links von einem Dokument zu anderen verlässlichen Quellen kann auf Fachwissen und Glaubwürdigkeit hinweisen. Saubere Linkprofile sind wichtig, um Vertrauenswürdigkeit zu schaffen.

- Ankertext und N-Gramme deuten darauf hin, dass kontextuell relevanter Ankertext in Links wichtig ist. Dies könnte auf Fachwissen zum Thema hinweisen.

- Entitätsbeziehungen: Der Nachweis klarer, genauer Beziehungen zwischen Entitäten in Inhalten kann auf Fachwissen und Glaubwürdigkeit hinweisen.

- Co-occurrence patterns: Das konsistente, relevante gemeinsame Auftreten verwandter Entitäten in Inhalten kann auf Fachwissen zu einem Thema hinweisen. Überprüfung der Anzahl der Vorkommen des Namens einer Entität in Ressourcen. Häufige, kontextuell angemessene Erwähnungen relevanter Entitäten können auf thematische Fachkenntnis hinweisen.

- Content Länge – Die Länge der Ressource wird berücksichtigt, was darauf hindeutet, dass umfassende, tiefgehende Inhalte bevorzugt werden.

-

- Abfrageunabhängiges Dokument zur langfristigen Benutzerbindung (wie CTR, Verweildauer)

- Hohe Klick-Raten im Vergleich zu anderen Ergebnissen für dieselbe Abfrage, was darauf hindeutet, dass die Seite als zuverlässiger angesehen wird.

- Konsistente Auswahl eines bestimmten Ergebnisses für eine Abfrage im Laufe der Zeit, was auf eine anhaltende Autorität in Bezug auf das Thema hindeutet.

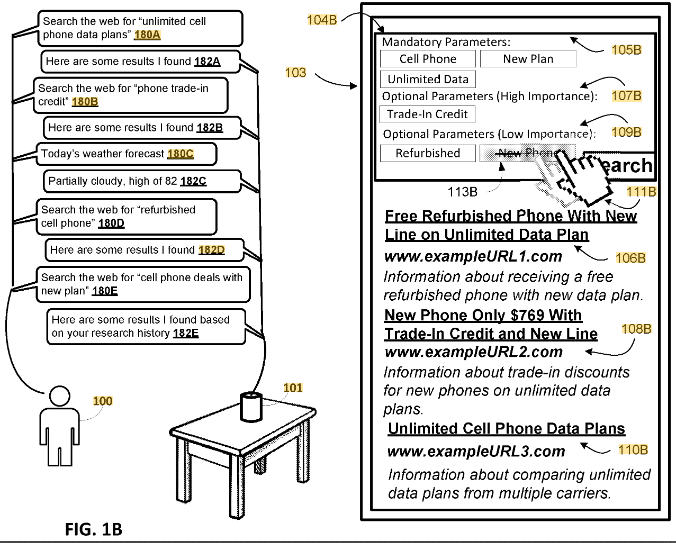

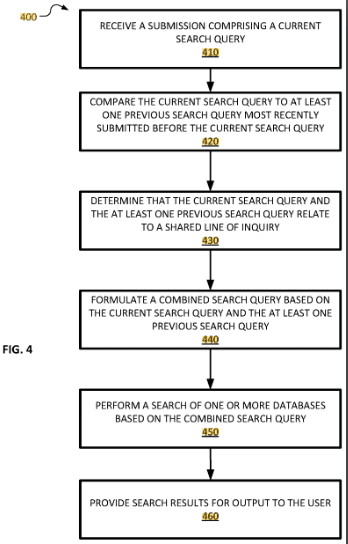

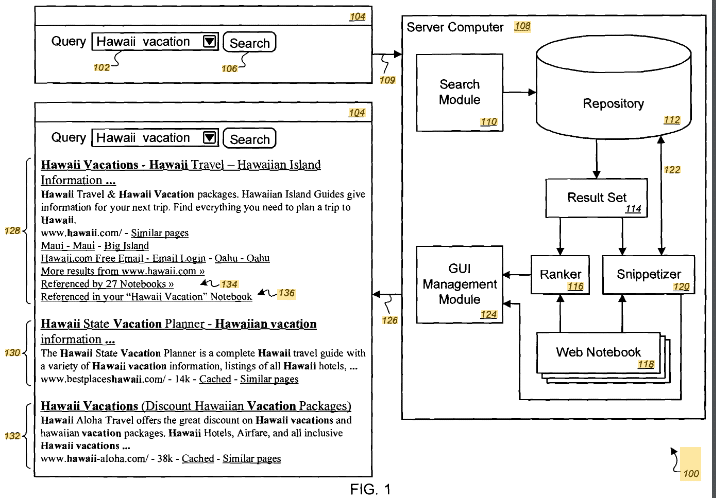

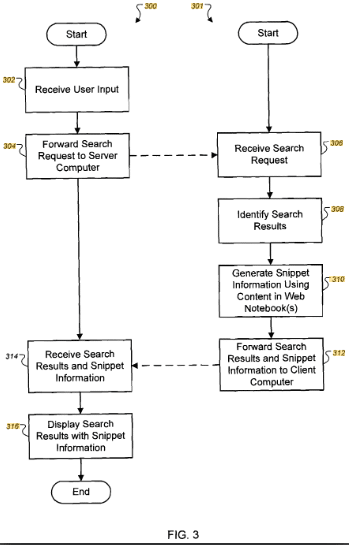

- Zuordnung mehrerer verwandter Abfragen zu einer einzigen zuverlässigen Seite, was auf eine umfassende thematische Abdeckung hindeutet.

- Suchbegriff-Entitäts-Auswahlwerte: Diese berechneten Werte spiegeln wider, wie gut Ressourcen mit der Absicht der Benutzer für bestimmte Suchbegriffe und Entitäten übereinstimmen.

- Direkte URL-Eingaben: Steigerung der Messungen der Verweildauer für Ressourcen, auf die über eine direkte URL-Eingabe zugegriffen wird, da dies auf eine positive Qualitätsbewertung durch den Benutzer hindeutet. Dies könnte als Signal für Vertrauen und Autorität gewertet werden.

E-E-A-T auf Dokumentebene steht für hilfreiche Inhalte und kann auf die gesamte Website oder auf Website-Bereiche übertragen werden. Die Summe hochwertiger hilfreicher Inhalte wirkt sich also auf die Domain-Ebene aus.

E-E-A-T auf Domain-Ebene (Qualitätsbewertung für die gesamte Website oder für einen bestimmten Bereich der Website)

Vertrauenswürdigkeit:

-

- Domain-Reputation: Der Domainname wird als Merkmal für die Klassifizierung berücksichtigt.

- Verknüpfung mit verifizierten Geschäftsinformationen: Einheitliche Geschäftsdaten wie Adressen und Telefonnummern.

- Geringerer Bedarf an Schlussfolgerungen: Durch die direkte Bereitstellung verifizierter Informationen zeigen Unternehmen Transparenz und Vertrauenswürdigkeit.

- Saubere Linkprofile: Ausgehende Links zu maßgeblichen Quellen signalisieren Vertrauenswürdigkeit.

- Nähe zu vertrauenswürdigen Startseiten: Kurze Entfernungen in Link-Diagrammen zu maßgeblichen Seiten.

- Faktische Genauigkeit: Verwendung von Knowledge-Based Trust (KBT) zur Bewertung der Richtigkeit von Fakteninformationen.

- Vorhandensein unangemessener Inhalte: Negative Signale wirken sich auf die Vertrauenswürdigkeit der Domain aus.

- Konsistenz zwischen den Signalen: Übereinstimmung von Informationen über Links, Titel und Inhalte hinweg.

- Langfristige Nutzerbindung auf der gesamten Website: Klickrate und Verweildauer auf der gesamten Domain.

- Übereinstimmung zwischen Domain-Namen und Firmennamen: Domain-Namen, die mit Firmennamen übereinstimmen, deuten auf einen offiziellen oder autoritativen Status hin.

- Verwendung von https

Autorität:

-

- PageRank und Link-Vielfalt: Unterschiedliche, hochwertige Links von seriösen Quellen.

- Historische Daten: Langfristige Konsistenz bei Rankings und Website-Leistung.

- Netzwerk verwandter Dokumente: Verknüpfte, relevante Inhalte, die die Autorität erhöhen.

- Domainweite Qualität: Website-weite Bewertung der Autorität, nicht nur einzelner Seiten.

- Passendes themenspezifisches Vokabular: Verwendung relevanter Begriffe und Konzepte für bestimmte Themenbereiche.

- Gleichbleibend hohe Rankings: Anhaltende Leistung bei verschiedenen Abfragen.

- Alter der Domain und des Inhalts auf der gesamten Website

- Gleichbleibend hohe Rankings: Ressourcen, die bei verschiedenen Abfragetypen (anfänglich und alternativ) durchgehend hohe Rankings erzielen, können als zuverlässiger angesehen werden.

- Entitätsreferenzen: Ressourcen, die relevante Entitäten genau und umfassend abdecken, können als zuverlässiger angesehen werden.

- Beständigkeit bei der Identifizierung als Navigationsressource für bestimmte Themen im Laufe der Zeit, wodurch Vertrauen und Autorität aufgebaut werden.

- Markenbekanntheit: Anfragen, die direkt auf eine Website oder Marke verweisen, können auf deren Autorität und Vertrauenswürdigkeit in den Augen der Benutzer hinweisen

Expertise und Erfahrung (hilfreicher Inhalt)

-

- Thematischer Fokus und Originalität des Inhalts: Originalinhalte, die relevante Themen gründlich abdecken.

- Aktualität der Inhalte: Regelmäßige Aktualisierungen und zeitnahe Überarbeitungen der Inhalte.

- Relevanz der Kategorien: Starke Leistung in relevanten Inhaltskategorien.

- Breites vs. Nischeninteresse: Nachweis von Fachwissen in Nischen- und breiten Themenbereichen.

- Vorhandensein unangemessener Inhalte

- Breites vs. Nischeninteresse – Ob eine Website ein breites oder ein Nischeninteresse hat, das sich auf thematische Fachkenntnisse beziehen kann.

- Historische Daten: Die Verwendung historischer Daten zur Qualität der Website deutet darauf hin, dass die langfristige Reputation und Konsistenz in die E-E-A-T-Bewertungen einfließen. Die Verwendung früherer Leistungskennzahlen deutet darauf hin, dass etablierte Fachkenntnisse und Autorität im Laufe der Zeit geschätzt werden können.

- Relevanz des Inhalts für häufig oder selten gesuchte Themen. Dies könnte auf Fachwissen in bestimmten Themenbereichen hinweisen, insbesondere bei Nischen- oder Fachinhalten.

- Umfassende Themenabdeckung, die sowohl Informations- als auch Navigationsabsichten erfüllt und die Tiefe des Wissens demonstriert. Detaillierte, gut strukturierte Inhalte, die ein Thema gründlich abdecken. Durch die Untersuchung von Makro- und Mikrokontexten, um die Tiefe und Relevanz von Inhalten zu bestimmten Themen zu verstehen, was auf die Qualität der Inhalte hinweisen könnte.

- Erstmaliger Inhalt – Inhalte, die erstmals zu einem bestimmten Thema veröffentlicht werden, werden höher bewertet, was auf Fachwissen und Autorität hinweist.

- Passendes typisches Vokabular für den Themenbereich: Domainlisten mit unverwechselbaren Begriffen für verschiedene Themenbereiche deuten darauf hin, dass Suchmaschinen den thematischen Fokus und die Autorität der gesamten Website bewerten können. Die Berücksichtigung wichtiger Begriffe und relevanter Entitäten deutet darauf hin, dass der Inhalt Schlüsselkonzepte und -entitäten im Zusammenhang mit dem Thema gründlich abdecken sollte.

- Verhaltensmuster der Benutzer: Übergänge von Informations- zu Navigationsabfragen signalisieren Fachwissen.

- Abfrageunabhängige langfristige Benutzerbindung auf der gesamten Website oder in bestimmten Bereichen (CTR, Verweildauer)

- Relevanz der Kategorie: Das Patent verwendet kategoriespezifische Dauerwerte zur Bewertung von Websites. Eine gute Leistung in relevanten Kategorien könnte Fachwissen und Autorität in diesen Themen signalisieren.

- Konsistente Leistung über Kategorien hinweg: Websites, die in mehreren relevanten Kategorien gut abschneiden, können insgesamt als zuverlässiger und vertrauenswürdiger angesehen werden.

E-E-A-T auf der Ebene der Source-Entity-Ebene

Vertrauenswürdigkeit

- Authentifizierung von Mitwirkenden: Überprüfung der persönlichen Informationen von Erstellern von Inhalten.

- Reputations- und Glaubwürdigkeitsverlauf: Erfolgsbilanz bei der Bereitstellung korrekter Informationen.

- Stimmung bei Erwähnungen und Bewertungen: Konsensstimmungsbewertung für die Entität.

- Einfluss von Kollegen und Empfehlungen: Bewertungen oder Empfehlungen von angesehenen Autoren.

- Vertrauensbeziehungen zwischen Entitäten: Berechnung von Vertrauensrängen auf der Grundlage der wahrgenommenen Vertrauenswürdigkeit durch andere Entitäten, was auf ein Vertrauensnetzwerk hinweist, das mit Autorität und Fachwissen in Zusammenhang stehen könnte.

- Beitragsmetrik: Basierend auf kritischen Bewertungen und Ruhm-Rankings belohnt diese Metrik wahrscheinlich Entitäten und Inhaltsersteller, die in ihrem Bereich bedeutende Beiträge geleistet haben.

- Nachbarschaftsqualität: Die Qualität der verknüpften oder verwandten Entitäten beeinflusst die Bewertung einer Entität, was darauf hindeutet, dass maßgebliche Verbindungen die E-E-A-T-Signale verstärken. Die Berücksichtigung von Zugehörigkeiten zwischen Dokumenten deutet möglicherweise darauf hin, dass Inhalte von etablierten Autoren oder seriösen Quellen höher bewertet werden.

- Reputation und Glaubwürdigkeitsverlauf – Die Erfolgsbilanz einer Entität bei der Bereitstellung zuverlässiger und genauer Informationen beeinflusst ihre Autorenbewertung.

- Die Häufigkeit der Veröffentlichung hochwertiger Inhalte wird als Faktor zur Verbesserung der Reputationsbewertungen genannt.

- Verifizierte Referenzen: Bildungshintergrund, Berufserfahrung und andere verifizierte Referenzen werden als Faktoren für die Glaubwürdigkeit eines Autors beschrieben.

Autorität

- Referenzen der Entität in autoritativen Quellen: Häufigkeit und Genauigkeit der Erwähnungen in autoritativen Quellen.

- Preis-Metrik: Auszeichnungen oder Anerkennungen, die mit der Entität verbunden sind, signalisieren Autorität.

- Häufigkeit der Inhaltszitate: Wie oft werden die Inhalte einer Entität von anderen zitiert?

- Veröffentlichungshistorie: Umfang und Konsistenz der Inhaltsbeiträge im Laufe der Zeit.

- Beitragsmessung: Bedeutende Beiträge im Bereich der Entität, basierend auf kritischen Bewertungen.

- Markenbekanntheit: Abfragen, die sich speziell auf die Entität beziehen.

- Die Übereinstimmung von Ankertext und Firmennamen deutet auf Anerkennung und Autorität für diese Entität hin.

- Präsenz in autoritativen strukturierten Online-Datenbanken und Enzyklopädien könnte ein E-E-A-T-Signal sein.

- Zitierhäufigkeit: Wie oft der Inhalt einer Entität von anderen glaubwürdigen Quellen zitiert wird, trägt zu ihrem Autoren-Score bei und signalisiert Fachwissen und Vertrauenswürdigkeit.

- Langfristige Konsistenz: Die Integrität historischer Daten und die Konsistenz der Identität eines Autors über verschiedene Plattformen hinweg werden als Faktoren für die Authentifizierungsbewertung genannt.

- Bemerkenswerte Typ-Metrik: Diese kombiniert die globale Popularität mit der Bedeutung des Entitätstyps, was darauf hindeutet, dass bekannte Entitäten in prominenten Kategorien bevorzugt werden könnten.

- Preis-Metrik: Diese spiegelt die Anerkennung und Auszeichnungen wider, die mit einer Entität verbunden sind, und signalisiert möglicherweise Fachwissen und Leistung.

- Autor: Assoziationen mit Themen basierend auf der beanspruchten Autorenschaft und der Interaktion der Benutzer mit ihren Inhalten, was auf Fachwissen in bestimmten Bereichen hindeutet.

- Benutzersitzungsdaten: Durch die Einbeziehung von Benutzersitzungsknoten in ein Diagramm kann das System bewerten, wie eine Ressource in umfassendere Muster der Benutzerrecherche passt, was möglicherweise auf ihre Autorität innerhalb eines Themenbereichs hindeutet.

- Anzahl der zu einem Thema veröffentlichten Inhalte nach Quelle

- Beliebtheit der Quelle

- Anzahl der Backlinks/Verweise auf die Quelle

- Anteil des Inhalts, den eine Quelle zu einem thematischen Dokumentenkorpus beigetragen hat

Expertise und Erfahrung:

- Erstinstanzlicher Inhalt: Pionierinhalte zu einem bestimmten Thema.

- Themenrelevanz: Die Übereinstimmung der Expertise des Autors mit dem Inhaltsthema.

- Veröffentlichungshistorie – Das Volumen, die Konsistenz und die Vielfalt der inhaltlichen Beiträge einer Entität im Laufe der Zeit werden berücksichtigt und können auf Erfahrung und Fachwissen hinweisen.

- Relevanz des Themas: Die Bedeutung des Fachwissens eines Autors für den von ihm erstellten Inhalt.

- Zeit bis zur letzten Veröffentlichung zu einem Thema der Quellentität

Diese Übersicht ist ein guter Ausgangspunkt für die Orientierung. Ich wäre Dir sehr dankbar, wenn Du dieses Wissen teilst und mich motivieren kannst, diese Übersicht regelmäßig zu aktualisieren. Danke!

Wenn Du mehr zum Thema E-E-A-T erfahren willst und ich erst einmal einlesen willst empfehle ich Dir die folgenden Beiträge:

- E-A-T (Expertise, Autorität, Trust) erklärt: Einfluss auf die Google-Rankings & Bedeutung für SEO

- E-A-T-Optimierung: Wie optimiert man E-A-T bei Google?

- E-A-T: Klassifizierung von Websites über Vektorraumanalysen nach Autorität und Expertise

- E-A-T & thematische Marken-Positionierung als kritischer Erfolgsfaktor in der SEO

Der Beitrag 80+ Faktoren für eine E-E-A-T-Bewertung durch Google erschien zuerst auf Aufgesang.

Case Study: 1400% Sichtbarkeitssteigerung in 6 Monaten durch E-E-A-T der Source Entity 24 Sep 2024 4:00 AM (6 months ago)

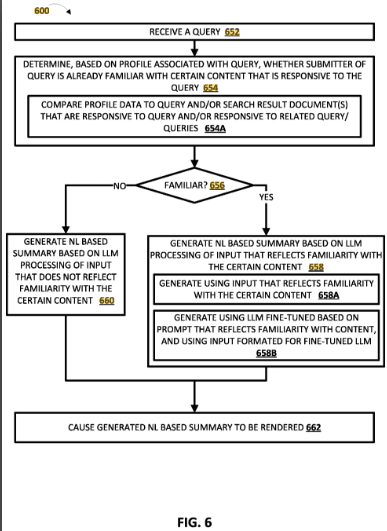

In diesem Artikel möchte ich die Hintergründe, Durchführung und Ergebnisse eines Tests aufzeigen, der der Domain aufgesang.de einen Sichtbarkeits-Boost von über 1400% in 6 Monaten beschehrt hat. Diese Case Study gibt Hinweise darauf wie mächtig E-E-A-T der Source Entity wirken kann. Zudem gibt einige weitere interessante Beobachtungen, die ich rund um diesen Test machen konnte und die einige bisherige Theorien zu E-E-A-T in Frage stellen.

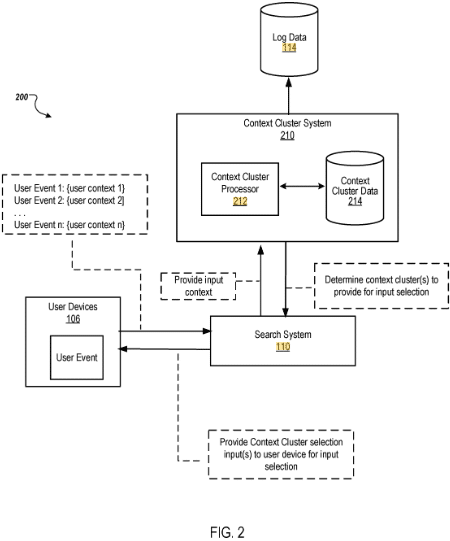

Hintergrund

Die Domain sem-deutschland.de gehörte mit zeitweise >5 Sichtbarkeitsindex bei Sistrix vor Dezember 2020 einige Jahre zu der sichtbarsten Agentur Webseiten im D-A-CH-Raum. Seit dem Core Update im Dezember 2020 verzeichnete die Domain bis zum August Core Update einen absteigenden Sichtbarkeitsverlauf meistens aufgrund der diverser Core Updates. Unsere zweite Agentur Domain aufgesang.de hatte bis zu diesem Jahr keinen großen Anspruch auf Rankings oder Sichtbarkeit und sollte in erster Linie den Brand-Traffic von Aufgesang bedienen. Ende letzten Jahres haben wir begonnen auch auf der aufgesang.de ein Fachwörter-Glossar aufzubauen, was in erster Linie SEO-Zielen verfolgt.

Im April habe ich mich dazu entschlossen einige ausgewählte Glossar-Beiträge von der sem-deutschland.de unverändert in das Glossar auf aufgesang.de zu übertragen. Alle dieser Beiträge haben gemeinsam, dass sie bis Ende 2020 Top 5 Rankings für Suchbegriffe >500 Suchanfragen pro Monat vorwiesen, dann aber aus den Top 10 rausgeflogen sind.

Bevor ich auf den Test und die Ergebnisse eingehe möchte ich die Theorie erläutern, die ich mit diesem Test stützen wollte.

Die Theorie für den Sichtbarkeits-Verlust

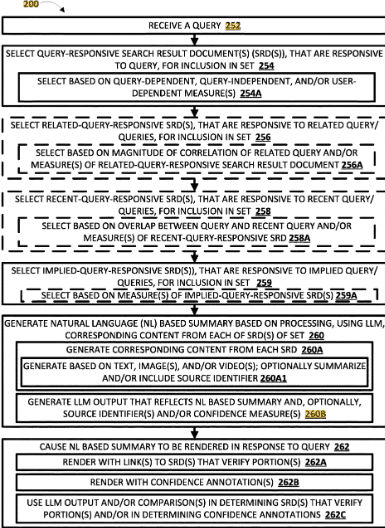

Wir können davon ausgehen, dass Google auf drei Ebenen oder Dimensionen Websites und Ergebnisse für das Ranking bewertet:

- Dokumenten-Ebene: Relevanz-Scoring auf Inhaltsebene nach klassischen IR-Scores z.B. nach BM25, TF-IDF, Nutzersignale …

- Domain-Ebene: Qualitätsbewertung auf seitenweiter oder Website-Bereichs-Ebene z.B. E-E-A-T. Die Domain ist digitale Repräsentanz der Source Enity.

- Source-Entity-Ebene: Als Source Entity bezeichne ich die Organisation/Publisher oder den Autor hinter den Inhalten einer Website. Für die Bewertung werden Brand-Signale genutzt wie Vorkommen und Suchmuster rund um die Brand, Brand Mentions, Kookkurrenzen aus Marke und Themen.

Mehr dazu im Beitrag Die Dimensionen des Google-Rankings

Die Source Enity Aufgesang ist aufgrund des Brand-Traffics, den sie erhält, mehr in Beziehung mit der Domain aufgesang.de als mit der Domain sem-deutschland.de.

aufgesang.de

aufgesang.de

sem-deutschland.de

sem-deutschland.de

Die Domain sem-deutschland.de wird mehr der Entität „Olaf Kopp“ zugeordnet als der Entität „Aufgesang“.

Hieran kann man gut erkennen, dass Google versucht Domains mit einer im Knowledge Graph erfassten Entität zusammenzubringen. Die Source Entity sem deutschland und die Domain sem-deutschland.de erhält selbst keine Brand-Signale, hängt damit etwas haltlos im Raum.

Meine Theorie war vor dem Umzug der Inhalte, dass die Brand-Stärke der Source Entity Aufgesang die gleichen Inhalte deutlich boostet und die alten Rankings für die identischen Inhalte auf der aufgesang.de wiederherstellt. Das wäre ein Hinweis auf den großen Einfluss von E-E-A-T der Source Entity auf das Ranking.

Um Zweifler an dieser Theorie etwas den Wind aus den Segeln zu nehmen, habe ich vorher natürlich das Backlinkprofil und Core Web Vitals der beiden Domains verglichen. Das Backlinkprofil von sem-deutschland.de war vor dem Umzug besser sowohl was Anzahl, als auch Qualität der Links. Wir haben seit 2010 durch die Veröffentlichung von Studien, Ebooks, Blogbeiträgen … viele hochkarätige Links für die sem-deutschland.de einsammeln können.

Auch die Core Web Vitals sind auf der sem-deutschland.de besser als die der aufgesang.de

Core Web Vitals aufgesag.de

Core Web Vitals sem-deutschland.de

Somit können diese beiden Faktoren schon mal asugeschlossen werden.

Das Test-Szenario

Ich habe 29 Inhalte ausgewählt, um sie unverändert im Zeitraum April bis August 2024 in das Glossar auf aufgesang.de umzuziehen. Die Artikel wurden in der Vergangenheit alle als relevant von Google bewertet und vor 2021 mit Top Rankings belohnt, haben mit der Zeit aber ihre Top 10 Positionen verloren.

Die alten URLs wurden per 301 weitergeleitet auf die neuen. Für die interne Verlinkung der Glossar-Beiträge nutzen wir bei beiden Domains WordPress Plugins für die automatische interne Verlinkung mit den Hauptkeywords als Ankertext. Der einzige Unterschied bei der Gestaltung der Glossar-Beiträge ist, dass auf aufgesang.de ich nicht als Autor genannt werde und auch keine Autorenboxen genutzt werden. Das sollte laut Theorie eigentlich ein Nachteil sein, aber die Ergebnisse zeigen, dass es sich überraschenderweise nicht als Nachteil herausgestellt hat.

Die Sichtbarkeits- und Ranking-Entwicklungen der einzelnen Inhalte überwache ich in mehreren Sistrix-Dashboards.

Ich möchte erwähnen, dass keine der gerade sehr gehypten Methoden wie Topical Mapping, Micro Semantics, Macro Semantics oder andere komplexe Ansätze bei der Produktion der Inhalte genutzt wurden. Die Relevanz-Optimierung wurde damals klassisch mittels TF-IDF-Analysen und W-Fragen-Recherche durchgeführt.

Die Testergebnisse

Die Domain aufgesang.de konnte seit April über 1400% an Sichtbarkeit zulegen. Die alten Rankings, die die Inhalte auf der sem-deutschland.de vor 2021 erreichen konnten sind nahezu alle wieder hergestellt und zum Teil sogar besser.

Betrachtet man die jetzige Gesamt-Sichtbarkeit beider Domains zusammen gab es einen Zuwachs von ca. 250% wobei erwähnt werden muss, dass August Core Update 2024 zum Teil zu einer Recovery bei der sem-deutschland.de geführt hat.

Sichtbarkeit der beiden Domains gestapelt

Fazit

Seit 2013 beschäftigt mich das Thema Entitäten- und Domain-spezifische Qualitätsbewertung. Schon bevor Google 2015 E-E-A-T in die Quality Rater Guidelines einführte hatte ich das Gefühl, dass es einflusstarke Rankingfaktoren gibt, die vor allem mit Digitalen Markenaufbau beeinflusst werden können. Mit E-E-A-T als Qualitäts- und Markenkonzept gab Google diesem Gefühl einen Namen.

Folgende Schlussfolgerungen möchte ich aus diesem Test ziehen:

- Die Vertrauenswürdigkeit und Autorität einer Seite hat einen sehr großen Einfluss auf Rankings, nicht nur für YMYL-Themen.

- Autorenboxen spielen keine große Rolle.

- Überraschenderweise scheint die Autorenschaft keine große Rolle zu spielen, sondern in erster Linie die Source Entity des Unternehmens oder Publishers selbst.

- E-E-A-T hängt vor allem von Brandbezogenen Makrofaktoren auf Domain- und Source-Entity-Ebene ab, weniger von den einzelnen Inhalten selbst. (siehe Grafik dazu)

Dieser Test gibt einen weiteren Hinweis, dass dieses „Gefühl“ nicht nur pure Theorie ist. Es gibt nur wenige Tests, die das Thema E-E-A-T und Brand-Einfluss auf das Ranking bisher untersucht haben. Dieser Test soll als eine der wenigen Case Studies dazu führen, dass die Sicherheit erhöht das Thema E-E-A-T mehr in den Fokus zu nehmen.

Mehr Details zu diesem Praxis-Case und mehr in unserem nächsten Webinar:

Der Beitrag Case Study: 1400% Sichtbarkeitssteigerung in 6 Monaten durch E-E-A-T der Source Entity erschien zuerst auf Aufgesang.

Digitaler Markenaufbau: Das Zusammenspiel aus (Online-)Branding & Customer Experience 7 Aug 2024 12:40 AM (8 months ago)

Digitaler Markenaufbau bzw. Branding ist eines der zentralen Themen im Online Marketing. Nachfolgend mehr zur wachsenden Bedeutung und zu den Merkmalen einer (digitalen) Marke, wie man über eine herausragende Customer Experience eine Marke aufbaut und wie man Branding digital messen kann.

Definition: Was ist digitaler Markenaufbau bzw. was ist Online-Branding?

Digitaler Markenaufbau oder Online-Branding beschreibt eine Methode des Brand-Managements. Beim digitalen Markenaufbau geht es um die Positionierung in einem oder mehreren thematischen Bereichen und Stärkung der Beziehung zwischen einer Marke mit potentiellen sowie bestehenden Kunden über die Customer Experience (Nutzererfahrung) mit digitalen Touchpoints.

Der Unterschied zum klassischen Branding bzw. Markenaufbau ist, dass beim digitalen Markenaufbau neben den Nutzern auch die Algorithmen der wichtigen digitalen Gatekeeper wie Suchmaschinen und soziale Netzwerke überzeugt werden müssen.

Markenaufbau bzw. Branding wird in den meisten Fällen durch digitale und analoge Touchpoints im Zusammenspiel gefördert.

Was sind mögliche Branding-Ziele?

Ziele von Markenaufbau und Branding sind

- der Aufbau und Verbesserung von Beziehungen mit potentiellen Kunden, bestehenden Kunden und Mitarbeitern sowie potentiellen Mitarbeitern (Employer Branding).

- der Ausbau und die Pflege von Beziehungen zu weiteren Stakeholdern wie Influencer und anderen Multiplikatoren.

- Positionierung der Marke als thematische Autorität.

- Bessere Sichtbarkeit und Auffindbarkeit im Internet bzw. bei den wichtigen Gatekeepern wie Google, Facebook …

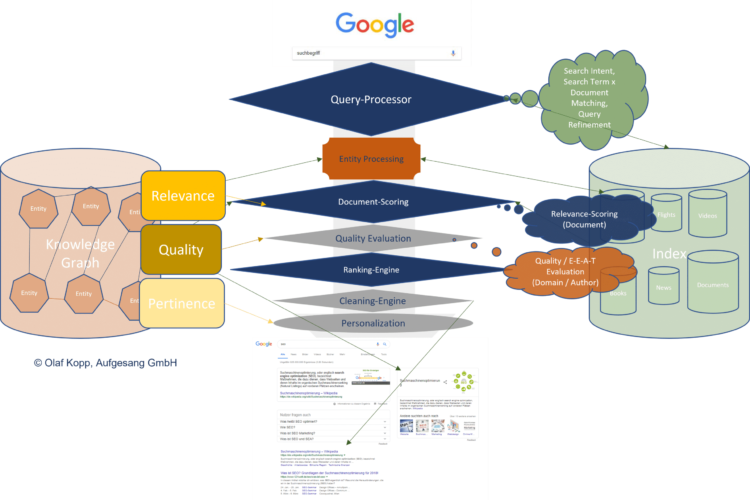

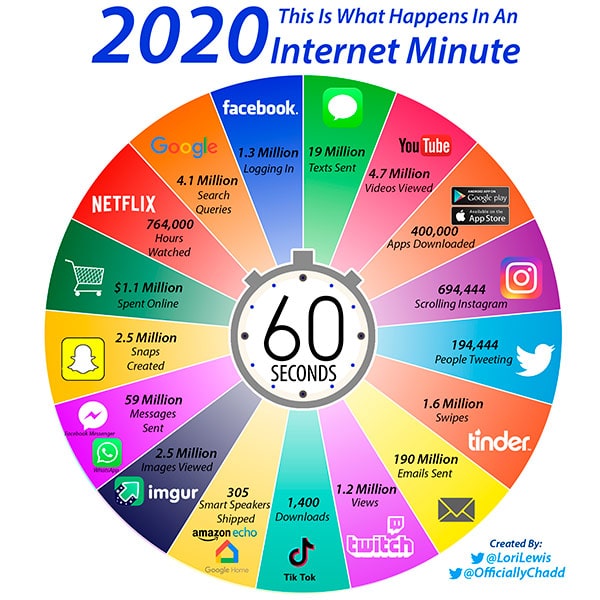

Das Web 3.0 als logische Konsequenz aus dem Web 2.0

Das Web 2.0 mit den einhergehenden technischen Möglichkeiten hat es quasi jedem ermöglicht Inhalte online über eigene Websites, Blogs und Social Media Profile zu veröffentlichen. Das führt zwangsläufig zu einer Überschwemmung des Netz mit Information und Daten, wie die folgende Infografik eindrucksvoll demonstriert.

Das Web 3.0 und die digitale Marke

Gatekeeper im Netz wie Google und Facebook wollen und können diese Marken und Autoritäten im Netz über Graphen identifizieren. Dabei spielt es primär erst einmal keine Rolle, ob man sich offline schon eine Marke aufgebaut hat oder nicht. Entitäten spielen in dieser Betrachtung eine wichtige Rolle.

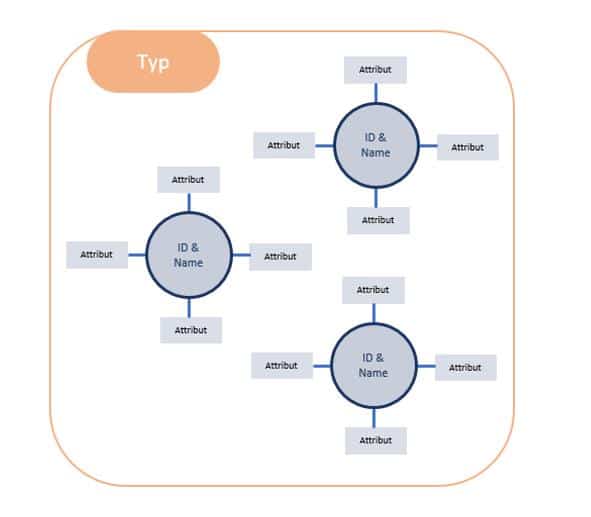

In der Semantik ist eine Entität eindeutig durch einen Identifier, einen Entitäts-Typ und bestimmten Eigenschaften gekennzeichnet.

Der Zusammenhang von Entitäten und Marken

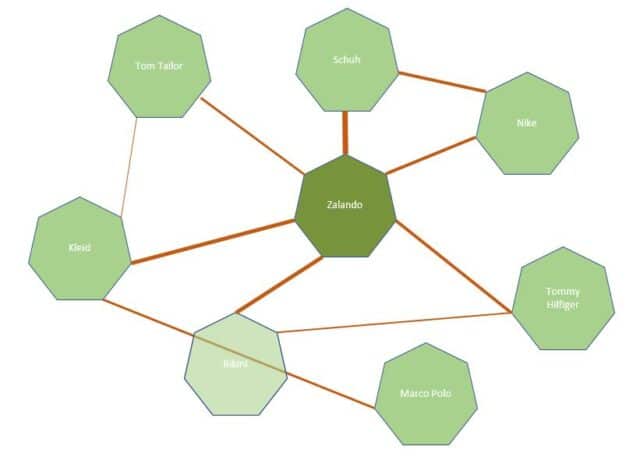

Entitäten sind in den meisten Fällen Teil mindestens einer Ontologie und können Personen, Bauwerke, Unternehmen etc. darstellen. Ontologien beschreiben das Umfeld in dem sich die Entitäten befinden. So ist Zalando eine Entität in des Entitätstyps Shop oder Händler und Teil der Ontologie z.B. Mode oder Mode-Shops und steht in Beziehung zu anderen Entitäten dieser Ontologien.

Beziehungen rund um die Entitaet Zalando

Starke digitale Marken sind im semantischen Web i.d.R. auch Entitäten mit hoher Relevanz mit vielen Schnittstellen zu anderen Entitäten in bestimmten thematischen Ontologien. Dies spielt auch für die Suchmaschinenoptimierung eine wichtige Rolle. Übertragen auf das Internet kann man Websites bzw. Domains als zentrales digitales Abbild einer Marke sehen.

Über Verlinkungen, Kookkurrenzen der Marke mit anderen Entitäten in Suchanfragen oder Online-Texten lassen sich Marken algorithmisch in Ontologien positionieren. Durch die Häufigkeit dieser Beziehungen bewerten hinsichtlich Autorität und Glaubwürdigkeit.

Mehr zum Thema Entitäten und Google findest Du in der ausführlichen Artikelreihe Semantische SEO: Entitäten, NLP & Semantik bei Suchmaschinen(Nur für Premium-Mitglieder) oder dem Einsteiger-Beitrag zum Thema Entitäten im Glossar.

Warum die digitale Marke im Online Marketing eine zentrale Rolle spielt

Es gibt mehrere Ursachen dafür, warum der Markenaufbau eine zentrale Rolle im (Online-)Marketing spielt.

- Die Marktlage in vielen Branchen.

- Die technische Entwicklung der wichtigsten Gatekeeper in Richtung des semantischen Web 3.0 .

- Die Bedeutung von vertrauenswürdigen und thematisch autoritären Quellen.

- Der Informations-Schock für Konsumenten

- Herausforderung zur automatischen Identifikation von vertrauenswürdigen und autoritären Anbietern und Informations-Quellen.

Unternehmen, die in der Vergangenheit nur auf das Performance-Marketing-Pferd gesetzt haben und Branding außer Acht gelassen haben, bekommen in vielen Bereichen Probleme sich im Internet zu behaupten. Dies ist begründet durch den über die Jahre gestiegenen Wettbewerbsdruck und das auf breiter Ebene gestiegene Know-How bzw. Ressourcen was Performance-Marketing angeht. Zudem befindet sich die Aufmerksamkeit für Werbeanzeigen im Sinkflug, nicht nur wegen den Ad-Blockern. Die Information muss zum Kontext des Nutzers passen, da sie sonst nicht durch das enge Aufmerksamkeits-Fenster des Nutzers durchkommt. Werbung als Touchpoint schafft das in in vielen Phasen der Customer Journey nicht.

Eine starke Marke kann Online-Marketing entscheidend zum Erfolg führen.

- Eine starke Marke kann zu besseren Abschlussraten bzw. Konversionsraten führen, da das Vertrauen in eine bekannte Marke größer ist.

- Das größere Vertrauen kann auch zu verbesserten Klickraten in den SERPs führen, was sich positiv auf das Google Ranking

- Etablierte Marken führen zugrößerer Kundenbindung und Loyalität, was sich in mehr wiederkehrenden Website-Besuchern und Kunden auswirken kann.

- Die Chance auf Verweise und Social Shares ist größer, da starke digitale Marken, aufgrund der Vertrauenswürdigkeiteher durch Multiplikatoren verlinkt, verwiesen bzw. Inhalte geteilt Das führt zu größerer Reichweite und besseren Rankings. Content-Marketing, SEO und PR wird einfacher.

- Marken, die sich in einem oder mehreren thematischen Bereichen als Autorität über die Domain etabliert haben,werden mit Inhalten eher bei Google gefunden als nicht etablierte Domains.

- Starke Marken profitieren, aufgrund der Popularität auch von besseren Klickraten bei derSuchmaschinenwerbung (SEA), was zur Verbesserung von Qualitätsfaktoren und damit geringeren Klickpreisen führt.

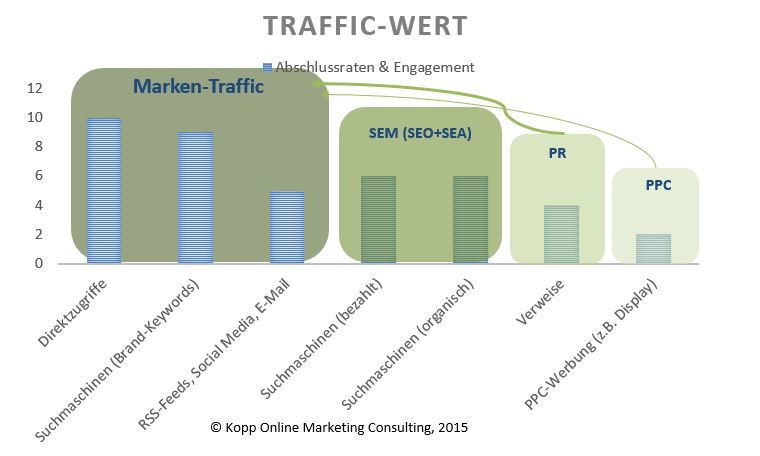

Zudem ist Marken-Traffic z.B. über Direktzugriffe oder Suchanfragen nach der Marke in Suchmaschinen zusammen mit den wiederkehrenden Besuchern der wertvollste Traffic.

Je höher der Anteil der Marken-Traffics, desto höher sind in den meisten Fällen die Engagment-Kennzahlen wie z.B. Seitenaufrufe, durchschnittliche Aufenthaltsdauer, Absprungrate … die Loyalitäts-Kennzahlen wie z.B. der Anteil der wiederkehrenden Besucher und vor allem die Abschlussraten.

Somit gibt es einen direkten Wirkungszusammenhang zwischen der Markenstärke und der Performance.

Der Aufbau einer Marke folgt einem strategischen nachhaltigen Ansatz mit dem Ziel Kundenloyalität und Reputation zu verbessern, was die nachhaltige Positionierung im Markt fördert.

Performance-Marketing hingegen ist oft eher taktisch/operativ und folgt nur selten einer Strategie der Positionierung als Marke.

Der Aufbau einer digitalen Marke ist kritischer Erfolgsfaktor und rückt in das Zentrum des Online Marketings, wo bisher alleinig das Performance-Marketing stand. Deswegen lässt sich Performance-Marketing und Branding nicht mehr voneinander trennen wie im Beitrag Warum die Diskussion um Branding vs. Performance im Marketing überflüssig ist erläutert.

Über eine herausragende Customer-Experience entlang der Customer-Journey eine Marke aufbauen

Menschen bauen Beziehungen mit Marken auf, indem sie positive Gefühle bei der Interaktion mit verschiedenen Kontaktpunkten mit der Marke empfinden. Hier spielt die Nutzererfahrung bzw. User- oder Customer Experience mit diesen Touchpoints eine wichtige Rolle. Touchpoints können z.B. sein:

- Content

- Werbe-Anzeigen

- Kontakt mit dem Vertriebs-Mitarbeiter bzw. Verkäufer

- Kontakt mit dem Service-Mitarbeiter

- ein Angebot

- Bestellabwicklung

- die Erfahrung mit dem Produkt in der Anwendung

Typische digitale Touchpoints sind:

- organisches Suchergebnis

- Produktdetailseite im Shop

- Ratgeber-Content im Blog

- Google Ads Anzeige

- Social-Media-Post

- Social Media Anzeige

- Display-Anzeige

- Bestellabschlussseite im Shop

- Kontaktformular

- Whitepaper

- …

Die Touchpoints müssen je nach Kontext den Nutzers

- emotional ansprechend sein

- rational ansprechend sein

- funktional ansprechend sein

- erwartungskonform sein

Alle Punkte werden je nach Person bzw.Kontext dieser individuell empfunden und bewertet. So sollten Touchpoints so gestaltet sein die wichtigsten Zielgruppen oder Personas dementsprechend zu befriedigen. Zudem sollten möglichst viele Touchpoints entlang der Customer Journey des Nutzers ausgerichtet an seinen Bedürfnissen konsistent sein. Inkonsistenz und Widersprüche führen zu Verwirrung und Einschränkung der Nutzererfahrung.

Hier einige Beispiele:

Ein Nutzer der in einer Suchmaschine nach „rückenschmerzen“ googlet hat eine bestimmte Suchabsicht bzw. Suchinintention. Er sucht objektive Informationen wie z.B. einen Ratgeber-Beitrag oder Video. Ein erwartungskonformes Suchergebnis wäre ein umfassender Ratgeber zu Symptomen, Ursachen, Behandlungsmöglichkeiten … Eine Produktvorstellung für ein neues Rheuma-Mittel wäre hingegen kein erwartungskonformer Touchpoint.

Gerade bei Touchpoints die auf eine Pull-Mechnanismus setzen wie z.B. organische Suchergebnisse bzw. Suchmaschinenwerbung und die dementsprechenden Zielseiten sollten sehr fokussiert auf die Erwartungskonformität achten, da sonst die Nutzererfahrung und damit die Marken-Wahrnehmung leidet.

Ein Nutzer klickt auf eine Display-Anzeige, die ihm suggeriert ein kostenloses Produkt erwerben zu können. Auf der Landingpage wird klar, dass das Produkt nicht kostenfrei ist. Die Folge ist eine negative Nutzererfahrung, da nicht erwartungskonform.

Ein Nutzer besucht eine Website, die unendlich lange lädt. Er will sich weiter durch die Website navigieren und bricht irgendwann verzweifelt ab, da jede Interaktion mit der Website zu lange dauert. Die Folge ist eine schlecht Customer Experience aufgrund schlechter Funktionalität.

Das gleiche gilt für nicht funktionierende Anwendungen wie z.B. Konfiguratoren oder Tools.

Ein Mitarbeiter eines Unternehmens postet einen Beitrag bei Facebook, der im Widerspruch zu den bisher an anderen Touchpoints kommunizierten Werten des Unternehmens steht. Es kommt zu einer emotionalen Verunsicherung und im schlimmsten Fall zu einem Shitstorm. Sowohl auf der erwartungs als auch auf emotionaler Ebene führt diese Inkonsistenz zu einer schlechten Nutzererfahrung.

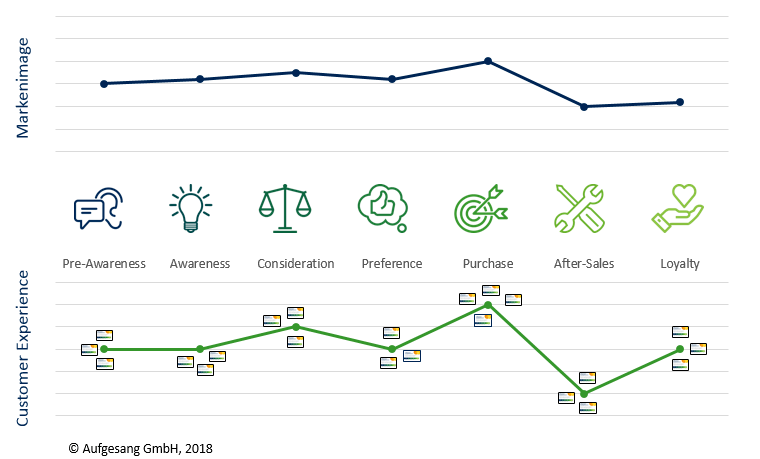

Die Customer Experience an den Touchpoints hat einen direkten Einfluss auf die Wahrnehmung der Marke. So können als positiv empfundene Touchpoints positiv für den Markenaufbau sein und umgekehrt.

Der Einfluss der Customer Experience an Touchpoints auf das Markenimage

Es wird kein Unternehmen auf der Welt geben, das alle Touchpoints herausragend gestalten kann. Deswegen ist es wichtig im Rahmen des Touchpoint- und Customer Journey Managements die erfolgskritischsten Touchpoints zu identifizieren, um diese mit Fokus zu gestalten und zu optimieren.

Die verschiedenen Ebenen für das Branding und die Gestaltung von Touchpoints

Für den Markenaufbau ist es wichtig die Marke in einen für den Nutzer verständlichen und einheitlichen Kontext zu verorten. Dieser Kontext hat mehrere Ebenen.

- Die thematische Ebene

- Die emotionale Ebene

- Die Beziehungs-Ebene

- Die funktionale Ebene

Die thematische Ebene

Um eine thematische Autorität in den Köpfen der Nutzer zu werden bedarf einer thematischen Einordnung der Marke. Gerade für B2B-Unternehmen oder als Anbieter teurer und/oder komplexer Dienstleistungen un Produkte spielt diese Ebene neben der Beziehungs-Ebene eine besondere Rolle.

Der Nutzer muss verstehen in welchen thematischen Bereichen meine Marke als relevant einzuordnen ist. Hier spielen Kookkurrenzen, also die immer wieder vorkommende Nennung meiner Marke in Verbindung mit Begriffen eines bestimmten Themas eine große Rolle. Je häufiger die eigene Marke im Zusammenhang mit den jeweiligen thematischen Kontexten bzw. deren typischen Begrifflichkeiten genannt wird, desto mehr Autorität wird der Marke in den Themenbereichen zugesprochen. Man kann hier auch von thematischer Positionierung sprechen.

Gerade auch für die algorithmisch gestützte Identifikation von thematischen Autoritäten bzw. Brands wie z.B. bei Suchmaschinen wie Google sind Kookkurrenzen messbare und damit nützliche Signale.

Die emotionale Ebene

Die emotionale Ebene spielt im Marketing eine herausragende Rolle für Kaufentscheidungen. In unserem Podcast mit der Neuromarketing-Spezialistin Gesa Lischka spricht sie sogar davon, dass unsere Kauf- und Konsum-Entscheidungen bis zu 90% durch Emotionen bestimmt werden und die rationale Entscheidung eine dementsprechend kleine Rolle spielt.

Ich sehe das etwas differenzierter und würde nach dem Produkt bzw. der Dienstleistung unterscheiden wollen welchen Anteil die drei Ebenen jeweils an der Kaufentscheidung haben.

Die emotionale Ebene wird stark durch Erscheinung, Haptik und weitere audiovisuelle Eigenschaften des Touchpoints bestimmt. Ist allerdings auch eine sehr individuelle Wahrnehmung.

Die Beziehungs-Ebene

Die Nähe zu anderen Brands, sei es Unternehmen oder Personenmarken wie z.B. Influencer spielt eine wichtige Rolle beim Brand-Building. Die Beziehung zu anderen Marken stärkt das Vertrauen in die eigene Marke beim Nutzer. Es ist eine Bestätigung und stärkt die Beziehung bzw. Bindung. Damit ist diese Ebene ein Verstärker der Effekte, die aus den anderen Ebenen entstanden sind.

Auch Signale für die Beziehungs-Ebene können von Algorithmen für Identifikation einer Marke genutzt werden.

Aber auch die Beziehung zu Repräsentanten der Marke wie Servive- und Vertriebs-Mitarbeiter oder anderen menschlichen Kontaktpunkten beeinflussen die Customer Experience und damit die Wahrnehmung einer Marke.

Die funktionale Ebene

Die Nutzerfreundlichkeit und damit die User Experience auch als Customer Experience bezeichnet wird auch durch die Funktionalität eines möglichen Touchpoints beeinflusst. Eine herausragende funktionale UX bei der Nutzung einer Dienstleistung bzw. eines Produkts ist eine wichtige Vorraussetzung für die Kundenbindung.

Aber auch Touchpoints in der Pre-Purchase-Phase z.B. beim Ausfüllen eines Kontaktangebots, Zustandekommen eines ersten Beratungsgesprächs, Nutzung von Anwendungen und Content im Rahmen der Neukundenakquise wie z.B. die Erreichbarkeit. Mobilfreundlichkeit, Ladezeit einer Website sollten eine herausragende funktionale Nutzererfahrung bieten.

Merkmale und Kennzahlen einer Marke

Übertragen auf das Internet kann man Websites bzw. Domains als zentrales digitales Abbild einer Marke wichtige Merkmale zuordnen. Eine digitale Marke erkennt man daran, dass die Marken-Website im Vergleich zum Durchschnitt der anderen Websites im Themenbereich / Branche eine größere Popularität vorweist. Kennzahlen für eine überdurchschnittliche Popularität können z.B. folgende sein:

- Besucherzahlen

- Anzahl neuer Besucher

- Suchvolumen nach Markenbegriffen

- Suchvolumen navigationsorientierter Suchbegriffe bezogen auf die Domain und Marke

- Social-Spread, Social Buzz, Sichtbarkeit in sozialen Netzwerken

Eine weitere wichtige Eigenschaft von Marken als auch Autoritäten ist die Kundenbindung und Loyalität. Loyalitäts-Kennzahlen können sein:

- durchschnittliche Aufenthaltsdauer

- Absprungrate

- Anteil wiederkehrender Besucher

Die wohl wichtigste Eigenschaft einer Marke und Autoriät ist das entgegengebrachte Ansehen und Vertrauen, das man anhand folgender externer Reputations-Kennzahlen bewerten kann:

- Kookkurrenzen und Co-Citations

- Marken-Nennungen und Verlinkungen

Ein weiteres Anzeichen für Vertrauen in eine Marke bzw. Website sind Kennzahlen, die den Interaktionsgrad aufzeigen. Dafür können folgende Engagement-Kennzahlen herangezogen werden:

- Abschlussraten

- weitere Interaktionen mit der Website wie Downloads, Kommentare …

- Beziehung zu anderen Marken, Autoritäten und Influencern

- Anzahl Seitenaufrufe (Page Impressions)

Abschlussraten haben natürlich auch immer etwas mit Maßnahmen bei der Conversion- und Usability-Optimierung zu tun, aber Engagement hat auch immer etwas mit Vertrauen in eine Website und damit auch die Marke zu tun.

Tools und Methoden zur Messbarkeit des Markenaufbaus

Es gibt verschiedene Methoden den Erfolg des eigenen Markenaufbaus nachzuverfolgen. Insbesondere verschiedene Google-Tools geben einen guten Aufschluss darüber wie populär, thematisch positioniert und vernetzt eine Marke ist.

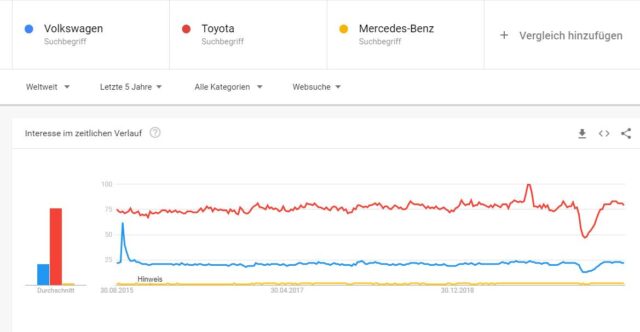

Google Trends

Über Google Trends lässt sich die Entwicklung der einer Marken-Nachfrage nachverfolgen. Hier zum Beispiel der Nachfrage-Verlauf nach den Automarken VW, Mercedes und Toyota in den letzten Jahren:

Google Trends eignet sich aber nur für Marken, die schon eine gewisse Popularität besitzen, da sonst keine Daten ausgegeben werden. Zudem ist es wichtig zu verstehen, dass sich Google Trends nicht als Tool zum direkten Wettbewerbsvergleich hinsichtlich der Popularität eignet, da die Y-Achse keine Vergleichsgröße darstellt. Mehr dazu in diesem Beitrag vom geschätzten Kollegen Tom Alby >>> 5 Gründe, warum Du Google Trends falsch verstehst.

Keyword Planer

Im Beitrag Warum E-A-T für das Ranking so wichtig ist und wie man E-A-T optimiert habe ich eine Methode erläutert wie man mit Hilfe des Keyword Planers die thematische Autorität einer Domain, also das digitale Abbild einer Marke ermitteln kann. Diese Methode ist nicht nur für SEOs interessant, sondern auch für Brand-Verantwortliche, da man erkennen kann in welchem thematischen Kontext die eigene Marke gegooglet wird bzw. mit welchen Begriffen die eigene Marke in Kookkurrenz gesucht wird.

Diese Methode lässt sich auch für den Wettbewerb durchführen.

Wenn man im Keyword-Planer über die Funktion „mit einer Website beginnen“ Keyword-Vorschläge abruft ergibt sich am Beispiel von zalando.de folgendes Bild:

Die Keyword sind nach einer durch Google undefinierten Relevanz sortiert. Überprüft man die ausgegebenen Keywords hinsichtlich dem Ranking wird klar, dass nahezu für alle dieser Keywords Zalando auf Top-Positionen rankt. Hier scheint eine thematische Autorität bzw. große Nähe zu bestimmten Themen und anderen Entitäten vorzuliegen.

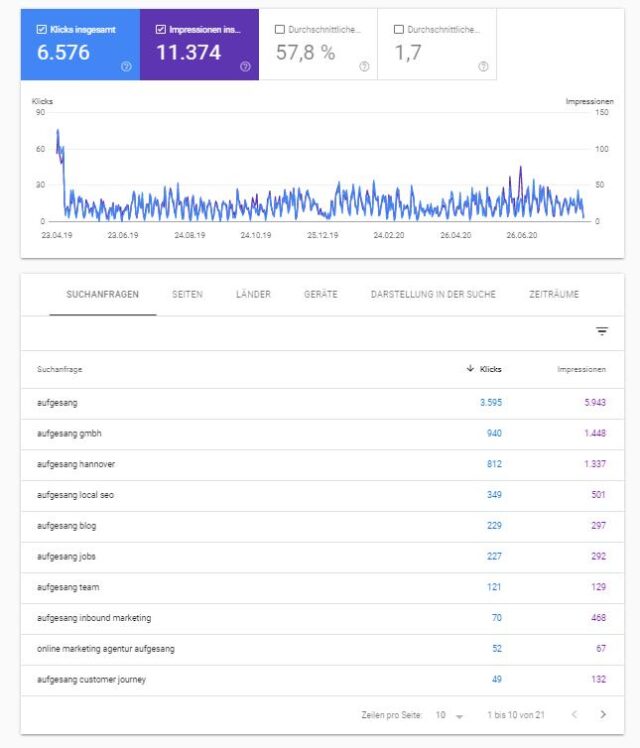

Google Search Console

Im Bericht „Leistung“ in der Search Console kann man sich maximal für die letzten 16 Monate die „Brand-Leistung“ im Zeitverlauf ansehen. Gerade mit Blick auf laufende oder gerade abgelaufene Branding-Kampagnen sehr spannend. Einfach den Bericht Leistung aufrufen, den gewünschten Zeitrahmen auswählen und als Suchanfrage die eigene Brand auswählen. Neben der Höhe des exakten Suchvolumens je Brand-Begriff in Form der Impressionen ist der zeitliche Verlauf spannend. Eine Marketing-Kampagne ,egal ob offline oder online, sollte hier Effekte zeigen.

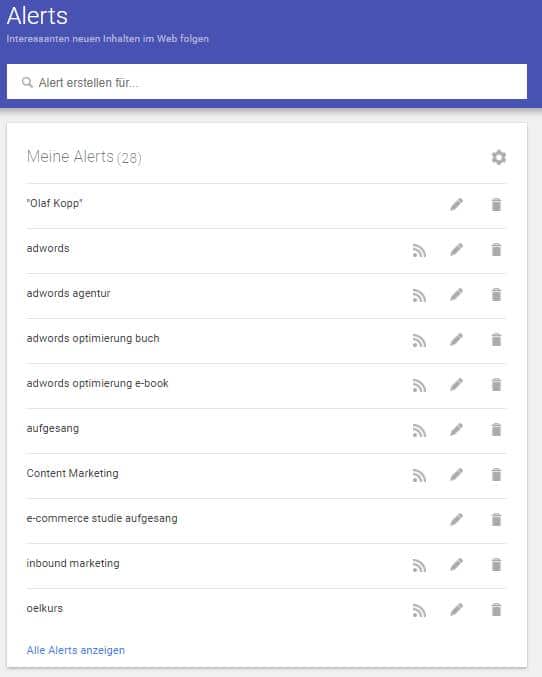

Google Alerts

Über die Google Alerts lassen sich Brand-Nennungen online überwachen. Einfach einen Alert auf die eigene Brand anlegen und man wird per E-Mail informiert, sobald die eigene Marke genannt wird.

Media Monitoring Tools

Eine kostenpflichtige Alternative zu Google-Alerts sind Media-Monitoring-Tools. Da wir in unseren Beiträgen Test: 5 Mediamonitoring-Tools im Vergleich und Online-Media-Monitoring: Tools können mehr, als Kampagnen evaluieren genauer darauf eingegangen sind möchte ich an dieser Stelle bei diesem Verweis belassen.

Google Analytics

Um das Engagement mit den Touchpoints auf der eigenen Website messen zu können eignen sich Web-Analyse-Tools wie Google Analytics. Am Ende diesen Beitrags findest Du ein kostenloses von mir erstelltest Google-Analytics-Dashboard zur freien Verwendung, das ich bei Zeiten aktualisieren werde.

Verwandte Suchanfragen bei Google und Google Suggest

Die verwandten Suchanfragen bei Google und Google-Suggest eignen sich dafür ähnlich wie der Keyword-Planer die thematischen Kookkurrenzen mit der eigenen Brand im Auge zu behalten. So geben die verwandten Suchanfragen zu meiner Personenmarke einen realitätsnahes Abbild zu meiner Positionierung wieder. Man findet diese am Ende der ersten Suchergebnisseite bzw. beim Eintippen einer Suchanfrage.

Das Auflösen der Silos für konsistent herausragende Touchpoint für das Branding

Wie in dem Beitrag Marketing wir haben ein Problem! Silos und fehlende Schnittstellen verhindern moderne Unternehmenskommunikation verhindern Silos in den meisten Unternehmen immer noch die konsistente Gestaltung und Verknüpfung der Touchpoints im Sinne des Brandings. So fallen Touchpoint hinsichtlich emotionalen, funktionale und thematischen Ebene häufig als auch der Nutzererfahrung unterschiedlich aus und verhindern die Wahrnehmung eines einheitlich positiven Markenbilds.

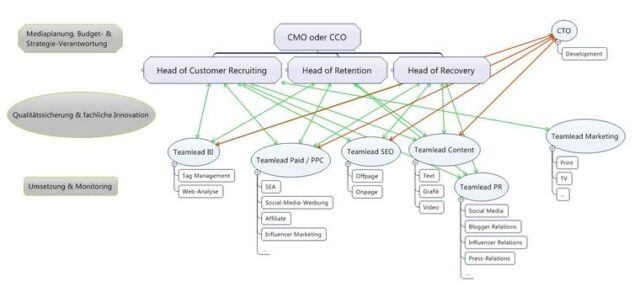

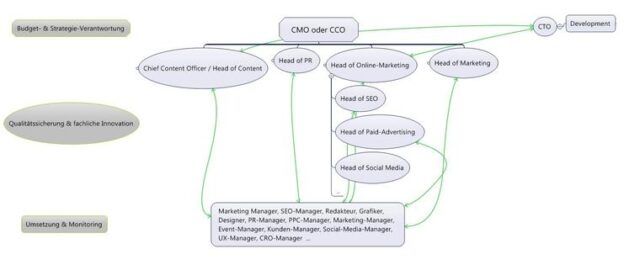

Unternehmen brauchen Strukturen, die es ermöglichen zumindest die wichtigsten Touchpoints innerhalb der Customer-Journey konsistent zu gestalten und miteinander sinnvoll zu verknüpfen.

So können die Customer-Journey-Phasen auch bei der Struktuierung eines Unternehmens als Grundlage dienen. So können die Fachabteilungen in der Hierarchie unterhalb einer Führung gemäß der einzelnen Customer-Journey-Phasen einsortiert werden.

Nutzerzentrierung in der Strukturierung des Marketings, © Michael Singer

Oder sorgt für eine Auflösung der Silos in der Umsetzungs-Ebene und die Zusammenarbeit bei der Gestaltung der Touchpoints besser zu ermöglichen.

Auflösung der Silos im Marketing auf der Umsetzungs-Ebene, © Olaf Kopp

Digitaler Markenaufbau entlang der Customer-Journey im Zentrum des modernen (Online-)Marketings

Ich bin mir sicher, dass Markenaufbau bzw. Branding das zentrale Thema im Online Marketing ist. Der wichtigste Erfolgsfaktor für ein Unternehmen ist die positive Wahrnehmung der Marke offline und online, sowohl bei den Zielgruppen als auch bei den wichtigsten digitalen Gatekeepern und deren Bewertungs-Algorithmen.

In erster Linie funktioniert heute der Aufbau einer digitalen Marke bzw. Online-Branding nicht mehr wie früher über reichweitenorientierte Push Werbung. Push-Werbung schafft es nur noch bedingt echte Beziehungen aufzubauen.

Die „Marken-Awareness“ über diese Marketing-Form hat besonders im Internet stark nachgelassen.

Beziehungsaufbauende und stärkende Touchpoints entlang der Customer-Journey bzw. User-Journey sind vor allem Touchpoints wie Content, der Kontakt mit Mitarbeitern in Vertrieb, Service … und die Nutzererfahrung mit dem Angebot/Produkt. Push-Werbung kann im richtigen zeitlichen und örtlichen Kontext unterstützen. Hier hilft die Customer-Journey als zentrales strategisches Modell diese Touchpoints zu verorten.

Diese erfolgskritischen Touchpoints werden am besten initial je Zielgruppe in Customer-Journey-Management-Workshops entwickelt. Hierzu hat mein Kollege Ulf Hendrik Schrader einen Beitrag zu veröffentlicht >>> In 4 Schritten zu einem integrierten Online-Marketing entlang der Customer-Journey

Der Aufbau einer digitalen Marke wird kritischer Erfolgsfaktor und rückt auch in das Zentrum des Online Marketings, wo bisher alleinig das Performance-Marketing stand.

Weitere Quellen von mir zum Thema digitaler Markenaufbau

Der Beitrag Digitaler Markenaufbau: Das Zusammenspiel aus (Online-)Branding & Customer Experience erschien zuerst auf Aufgesang.

Google Helpful Content: Was wirklich wichtig ist! 13 Jul 2024 5:17 AM (9 months ago)

Seit dem ersten Helpful Content Update in 2022 macht sich die SEO-Welt Gedanken darüber wie man „hilfreiche Inhalte“ erstellen oder ihn dahingehend optimieren kann. Es werden Hypothesen aufgestellt, Analysen, Checklisten und Audits erstellt. Ich blicke auf die meisten dieser Ansätze mit etwas Skepzis, da die Analyse-Erkenntnisse oft den Fokus auf die Eigenschaften des Contents selbst haben und aus der Sicht eines Menschen und nicht einer Maschine bzw. Algorithmen hergeleitet werden. Google ist eine Maschine, kein Mensch!

Mein SEO-Mantra ist: „Think like an engineer, act like a human.“

Deswegen nähere ich mich in diesem Artikel dem Thema Helpful Content mit der Frage: Wie Google helpful content algorithmisch identifizieren kann und was sinnvoll ist.

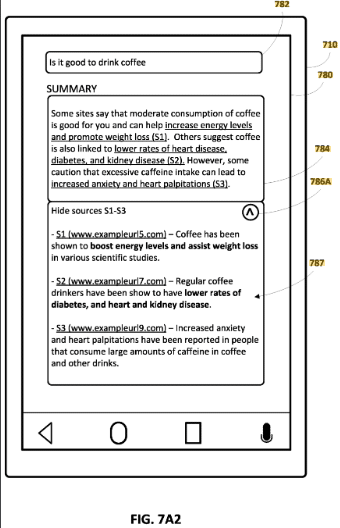

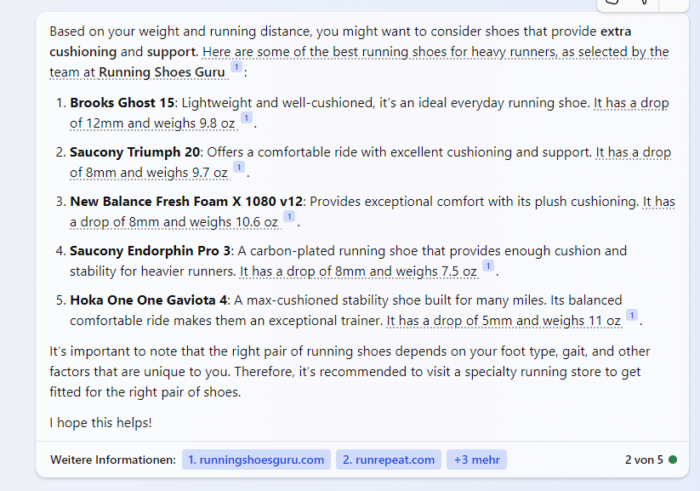

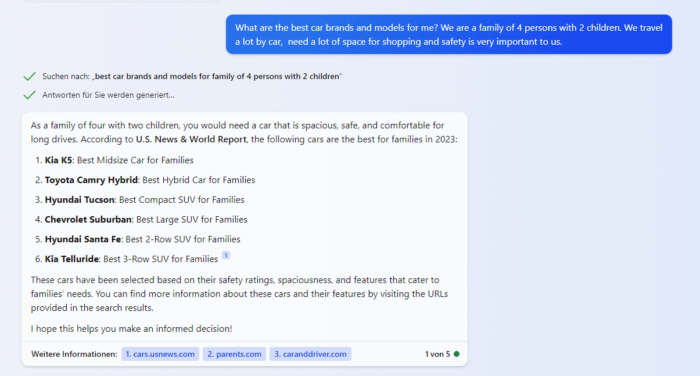

Helpful Content, was ist das überhaupt?

Helpful Content ist eine Terminologie, die Google im Rahmen des ersten Hepful Content Updates im August 2022 eingeführt hat. Zuerst hatte Google angekündigt, dass es sich beim Helpful Content System, um einen „sitewide Classifier“ handelt. Später wurde bekannt, dass es auch für die Bewertung von einzelnen Dokumenten genutzt wird.

Our helpful content system is designed to better ensure people see original, helpful content written by people, for people, in search results, rather than content made primarily to gain search engine traffic.

Unsere zentralen Ranking-Systeme sind in erster Linie für den Einsatz auf Seitenebene konzipiert. Anhand verschiedener Signale und Systeme wird die Nützlichkeit der einzelnen Seiten ermittelt. Es gibt auch einige websiteweite Signale, die ebenfalls berücksichtigt werden.

Ich habe mich bereits im Rahmen des ersten Helpful Content Updates dazu geäußert, dass dieses Update nicht nur aufgrund des bedeutungschwangeren Titels vor allem ein PR-Update war. Meine Herleitung und Kritik kann man hier im Detail nachlesen.

Ein PR-Ziel von Google ist es Website-Betreiber dazu zu animieren Crawling, Indexierung und damit die Bewertung einfacher zu machen. Das war zumindest das Ziel der größten Updates wie z.B. die Umstellung auf Page Speed Update, Page Experience Update, Spam Update … Diese Updates haben eins gemeinsam. Sie implizieren durch den vielsagenden konkreten Titel eine Handlungsempfehlung und helfen damit Google beim Information Retrieval.

Ich hätte das Helpful Content System eher „User Satisfaction System“ genannt. Aber dazu später mehr.

Was ist hilfreich?

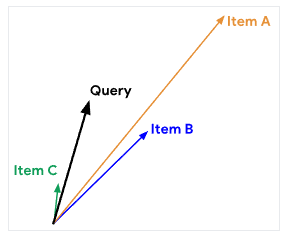

Um diese Frage zu beantworten, sollte man sich etwas mit den Information-Retrieval-Begriffen Relevanz, Pertinenz und Nützlichkeit beschäftigen. Wie in meinem Artikel „Relevanz, Pertinenz und Qualität bei Suchmaschinen“ beschrieben sind diese Begriffe wie folgt beschrieben:

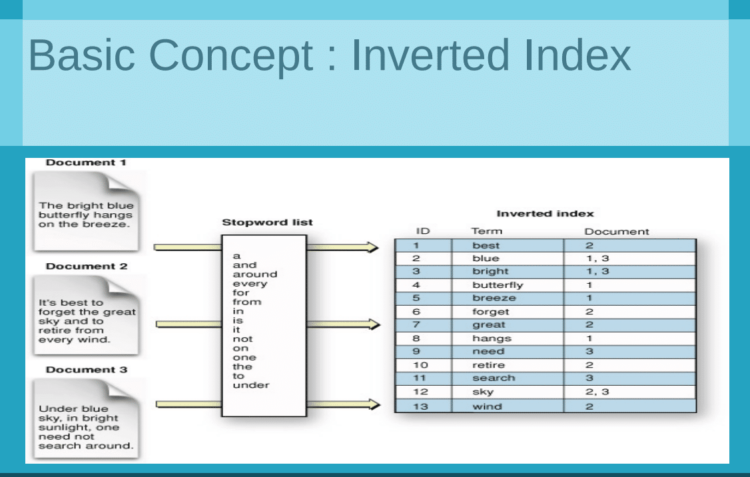

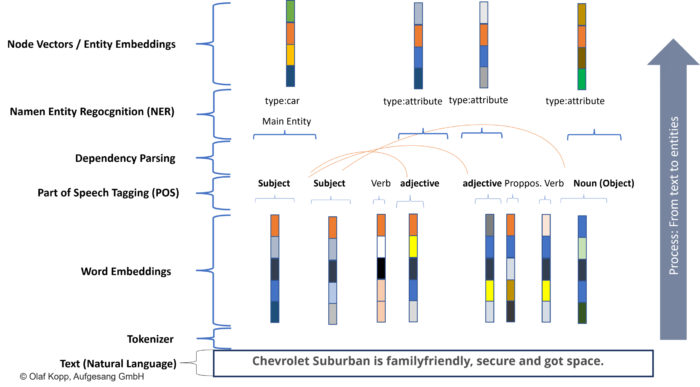

Relevant ist etwas für Suchmaschinen wenn ein Dokument bzw. Inhalt in Bezug auf die Suchanfrage bedeutsam ist. Die Suchanfrage beschreibt die Situation und den Zusammenhang. Diese Relevanz ermittelt Google über Methodiken der Textanalyse, wie z.B. BM25, WDF*IDF bzw. TF-IDF, Word2Vec …

Pertinenz beschreibt die subjektive Bedeutsamkeit eines Dokuments für den Nutzer. Das bedeutet neben dem Match mit der Suchanfrage kommt eine subjektive Nutzerebene dazu.

Nützlichkeit schränkt neben den Bedingungen für Relevanz und Pertinenz die Ebene der Neuartigkeit mit ein.

Pertinenz und Nützlichkeit sind für mich die beiden Ebene, die für helpfulness stehen.

Objektive Relevanz an sich ist nicht wirklich hilfreich, da jeder Nutzer unterschiedliche Absichten, Wissensstände … hat. Für eine Suchmaschine gilt es herauszufinden, welche Inhalte Nutzer als hilfreich und nützlich empfinden. Daher ist der fokussierte Blick auf die Nutzer-Interaktion bzw. das Nutzerverhalten im ersten Schritt sinnvoller, anstatt die Beschaffenheit eines Inhalts zu bewerten.

Wie kann man algorithmisch helpfullness bzw. Pertinenz und Nützlichkeit messen?

Die Pertinenz und Nützlichkeit lässt sich über die Zufriedenheit der Nutzer mit dem Inhalts ermitteln. Die beste Methode, um die Zufriedenheit von Nutzern festzustellen ist die Messung und Interpretation des Nutzerverhaltens. Das gibt neben der Relevanz des Inhalts zur Suchanfrage einen besseren Aufschluss darüber, ob Nutzer einen Inhalt im jeweiligen Kontext wirklich hilfreich finden. Die Analyse von Dokumenten oder Inhalts-Eigenschaften sagt nur bedingt etwas darüber aus wie hilfreich ein Inhalt ein Suchergebnis ist, da der Nutzer hier nicht berücksichtigt wird.

Hierfür gibt es verschiedene mögliche Metriken, die aus dem Google API Leak hervorgehen:

- CTR (Click-Through Rate)

ctrWeightedImpressions: This attribute tracks the weighted impressions for calculating CTR.- Source: GoogleApi.ContentWarehouse.V1.Model.IndexingSignalAggregatorAdaptiveIntervalData

- Good Clicks

goodClicks: This attribute tracks the number of good clicks.lastGoodClickDateInDays: Indicates the date when the document received the last good click.- Source: GoogleApi.ContentWarehouse.V1.Model.QualityNavboostCrapsCrapsClickSignals

- Bad Clicks

badClicks: This attribute tracks the number of bad clicks.- Source: GoogleApi.ContentWarehouse.V1.Model.QualityNavboostCrapsCrapsClickSignals

- Long Clicks

lastLongestClicks: This attribute tracks the number of clicks that were the last and longest in related user queries.- Source: GoogleApi.ContentWarehouse.V1.Model.QualityNavboostCrapsCrapsClickSignals

- Short Clicks

- While there isn’t a direct attribute named „short clicks,“ the absence of long clicks or a high number of bad clicks could imply shorter interactions.

- Source: GoogleApi.ContentWarehouse.V1.Model.QualityNavboostCrapsCrapsClickSignals

Quelle: Google API Leak Analyzer

Weitere Faktoren, die ich aus Google Patenten recherchiert habe sind:

-

Click-Through Rate (CTR):

- Search Result Interaction: The percentage of users who click on a website link when it appears in search results.

- Ad Performance: CTR for advertisements displayed on the site.

-

Dwell Time:

- Average Time on Site: The average time users spend on the page after clicking a search result.

- Bounce Rate: The percentage of visitors who leave the site after viewing only one page.

-

Good Clicks and Bad Clicks:

- User Engagement Metrics: Metrics like page interactions (likes, shares, comments), bounce rates, and return visits.

- Viewing Time: Longer views are given higher relevance, indicating good clicks, while shorter views are given lower relevance, indicating bad clicks.

-

Long Clicks and Short Clicks:

-

Viewing Length: Measures the duration of time users spend viewing each document. Longer views (long clicks) are considered more relevant.

-

Weighting Functions: Applies continuous and discontinuous weighting functions to adjust relevance scores based on viewing time.

-

Patente:

-

-

- „Ranking Factors or Scoring Criteria“

- „Increased Importance of User Engagement Metrics“

- „User Engagement as a Ranking Factor“

-

Quelle: Database Research Assistant

Die Nützlichkeit lässt sich durch Suchmaschinen zusätzlich über einen Information Gain Score ermitteln.

Der Information Gain bzw. Informationsgewinn bezieht sich auf einen Score, der angibt, wie viele zusätzliche Informationen ein Dokument über die üblichen Informationen hinaus enthält, die in den von einem Nutzer zuvor angesehenen Dokumenten enthalten sind.

Dieser Wert hilft bei der Bestimmung, wie viele neue Informationen ein Dokument dem Benutzer im Vergleich zu dem, was der Benutzer bereits gesehen hat, bietet.

Mehr zum Information Gain findest du im Artikel Information Gain: Wie wird er berechnet? Welche Faktoren sind entscheidend?

Identifikation von hilfreichen Dokumenten-Eigenschaften, anhand der Nutzersignale

Eine weitere Möglichkeit ist über positive Nutzersignale in statistisch valider Menge vermeintliche Dokumenten-Eigenschaften oder Dokumenten-Muster zu identifzieren, die für Nutzer hilfreich sein könnten.

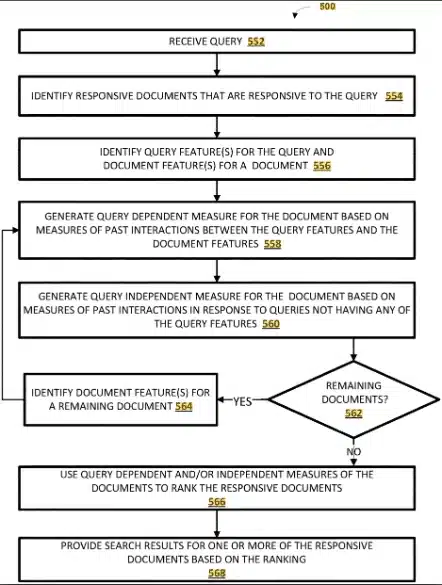

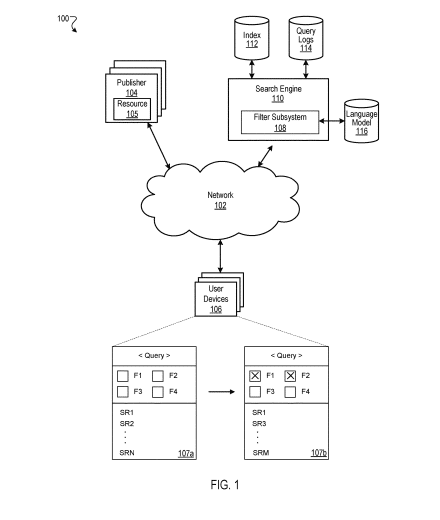

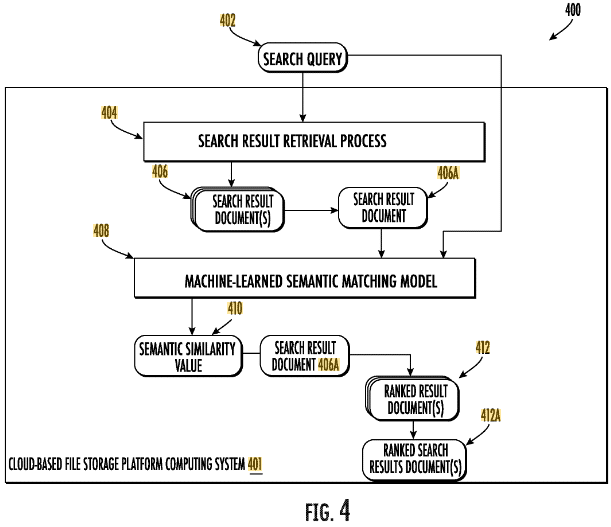

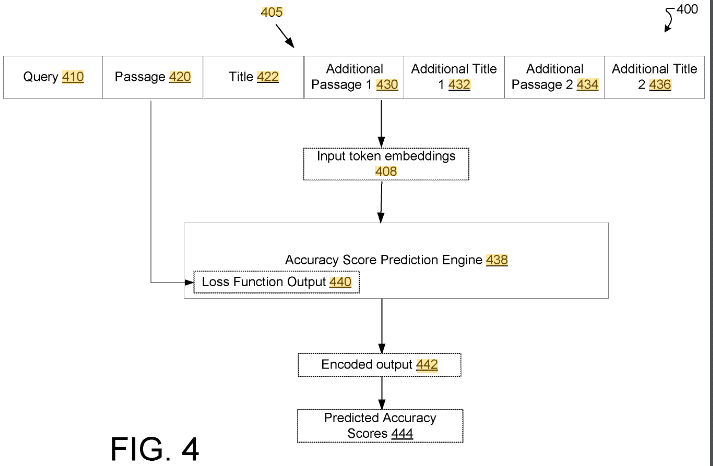

In dem Google Patent „Ranking Search Result Documents“ wird eine Methodik beschrieben, die aufgrund der vergangenen Nutzer-Interaktionen u.a. Eigenschaften der Suchanfragen mit Dokumenten Eigenschaften abgleicht.

Diese Methode würde allerdings viel Rechner-Ressourcen kosten. Zudem hätte eine solche Methodik immer einen größeren Zeitversatz zur Folge bis die Ergebnisse aussagekräftig sind.

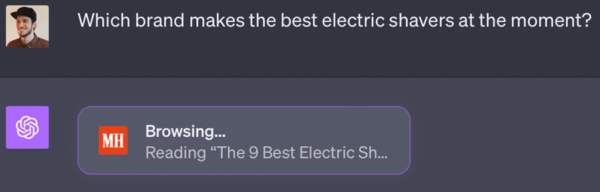

Das Zusammenspiel aus initialen Ranking und Reranking

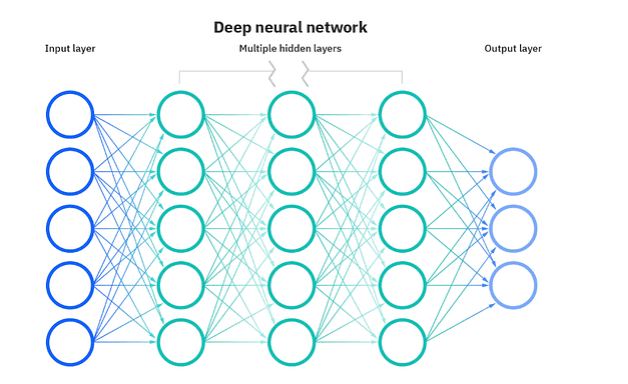

Um zu verstehen an welcher Stelle des Ranking Prozess helpful content ermittel wird ein kurzer Exkurs in Teile des Information Retrieval Prozess.

Im Ranking-Prozess gibt es drei Schritte:

- Dokumenten Scoring

- Quality Classification

- Reranking

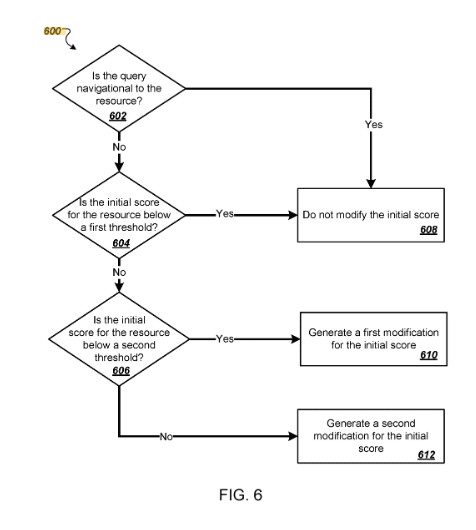

Das Dokumenten Scoring ist für das initiale Ranking der Top-n Dokumente zuständig. Hier wird ein sogenannter Ascorer genutzt, um IR-Scores zu errechnen. Wie hoch das das n ist nur zu vermuten. Ich gehe hier aus Performance-Gründen von maximal wenigen hunderten Dokumenten aus.

Bei der Quality Classification spielen vor allem Signale mit Bezug zu E-E-A-T eine Rolle. Hier wird die Beschaffenheit der einzelnen Dokumente nicht bewertet, sondern seitenweite Klassifikatoren eingesetzt.

Beim Reranking werden sogenannte Twiddler eingesetzt.

Twiddlers are components within Google’s Superroot system designed to re-rank search results from a single corpus. They operate on ranked sequences rather than isolated results, making adjustments to the initial ranking provided by Ascorer. There are two types of Twiddlers: Predoc and Lazy.

- Predoc Twiddlers:

- Operation: Run on thin responses (initial search results with minimal information).

- Functions: Modify IR scores, reorder results, and perform remote procedure calls (RPCs).

- Use Case: Suitable for broad, initial adjustments and promoting results based on preliminary data.

- Lazy Twiddlers:

- Operation: Run on fat results (detailed document information).

- Functions: Reorder and filter results based on detailed content analysis.

- Use Case: Ideal for fine-tuning and filtering based on specific content attributes.

For more detailed information, you can refer to the „Twiddler Quick Start Guide“ here.

Quelle: Database Research Assistant

Diese Twiddler können laut dem API-Leak neben der Dokumenten-Ebene auch für die Bewertung auf Domain-Ebene genutzt werden.

Twiddlers are used in Google’s ranking and indexing processes to adjust the relevance and ranking of documents. They are essentially factors or signals that can be „twiddled“ or adjusted to fine-tune the search results. Here are some key points about twiddlers based on the provided documents:

-

-

Domain Classification:

- Twiddlers can be used to classify the domain of a document, which helps in understanding the context and relevance of the content.

- Source: „qualityTwiddlerDomainClassification“ – Google-Leak_API-Module_zusammengefasst

-

Spam Detection:

- Twiddlers play a role in identifying and mitigating spam. They can adjust the ranking of documents that are flagged by spam detection algorithms.

- Source: „spamBrainSpamBrainData“ – Google-Leak_API-Module_zusammengefasst

-

Content Quality:

- Twiddlers can influence the perceived quality of content by adjusting scores based on various quality signals.

- Source: „commonsenseScoredCompoundReferenceAnnotation“ – Google-Leak_API-Module_zusammengefasst

-

Shopping and Ads:

-

For e-commerce and shopping-related queries, twiddlers can adjust the relevance of shopping annotations and ads.

-

Source: „adsShoppingWebpxRawShoppingAnnotation“ – Google-Leak_API-Module_zusammengefasst

-

-

Quelle: Google API Leak Analyzer

Die Twiddler sind ein Teil von Googles Superroot für ein nachgelagerte Qualitätsbewertung im Sinne von u.a. auch helpfullness auf einer Dokumenten- und Domain-Ebene verantwortlich.

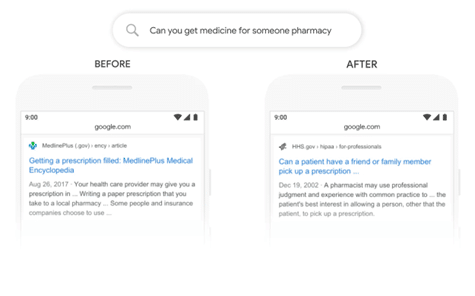

Quelle: Interne Google Präsentation „Ranking for Research“, November 2018

Für die Bewertung hinsichtlich Helpful Content machen objektive Rankingfaktoren, ausser Information Gain, keinen Sinn, da sie nicht den Nutzer im Fokus haben. Diese Faktoren werden vor allem beim initialen Ranking über den Ascorer berücksichtig.

Es macht Sinn, dass Google Helpful Content vor allem anhand der verschiedenen möglichen Nutzersignalen und einem Information Gain Score bewertet, der aber auch sehr personalisiert Nutzer individuell bewertet werden kann.

Helpful Content hat eine Korrelation mit dem Content, ist aber kausal zu den Nutzersignalen

Wie eingangs erwähnt bin ich skeptisch, was viele Analysen und Checklisten hinsichtlich Helpful Content angeht, weil ich denke, dass Google helpfullness vor allem aufgrund von Nutzersignalen bewertet und nicht aufgrund von Dokumenten-Eigenschaften. Sprich eine Analyse einzelner Inhalte hinsichtlich helpfullness ohne Einblick in Nutzerdaten zu haben halte ich für nur bedingt aussagekräftig.

Natürlich möchte man mit der Optimierung von Inhalten die Nutzersignale verbessern, aber am Schluss entscheidet der Nutzer, ob er/sie einen Inhalt hilfreich findet oder nicht und nicht der SEO, der bestimmte Eigenschaften eines Dokuments gemäß einer Checkliste optimiert.

Zudem ist die Entscheidung des Nutzers, ob er/sie einen Inhalt hilfreich findet abhängig von Thema und Kontext. Sprich die Empfehlungen zur Optimierung sind auch immer davon abhängig.

Es kann Korrelationen zwischen Dokumenten Eigenschaften zu Helpful Content geben, aber am Schluss besteht die Kausalität zu den Nutzersignalen.

Mit anderen Worten: Wenn man ein Content optimiert und sich die Nutzersignale nicht verbessern, wird dieser auch nicht hilfreicher. Google muss erst anhand der Nutzersignale lernen was hilfreich ist.

Interne Google Präsentation „Google is magical“, Oktober 2017

Diese These wird untermauert durch die Erkenntnnisse, die man aus dem Antitrust-Verfahren gegen Google ziehen konnte. Demnach ist das Verständnis / Qualität eines Inhalts nur aufgrund des Dokuments selbst nur bedingt abzuleiten.

Quelle: Interne Google Präsentation „Ranking for Research“ von November 2018

Der Wunsch nach einer Blaupause am besten in Form von Checklisten ist in der SEO-Branche groß. Deswegen bekommen sie auch immer große Aufmerksamkeit und sind populär. Sie hängen der Zeit aber hinterher, da sich das Bedürfnis und damit die helpfullness eines Inhalts je Suchanfrage sehr dynamisch sein kann.

Auch der Wunsch nach Klarheit,was z.B. Google Updates und mögliche Gründe für eine Abstrafung angeht ist groß. Deswegen sind Analysen der Google Updates auch sehr beliebt.

Aber wenn der Content King ist, sind Nutzersignale Queen und sie bestimmen am Schluss für wie hilfreich ein Inhalt von Google bewertet wird. Da die meisten Analysen hinsichtlich Core Updates und Helpful Content sich an den Eigenschaften von Dokumenten und Domains orientieren stellen sie maximal Korrelationen dar, aber keine Kausalitäten dar.

Eine Theorie wie z.B. Google wertet Websites wegen Affiliates-Links ab oder weil sie nicht die richtigen Entitäten oder Keywords erwähnen ist nicht sinnvoll. Google wertet Websites ab, weil die Nutzersignale nicht entsprechend sind und sie keinen Information Gain bieten, somit nicht den Nutzerbedürfnissen entsprechen und damit für viele Nutzer nicht hilfreich sind. Google wertet Seiten im Reranking nicht ab wegen bestimmter Dokumenten-Eigenschaften.

Für mich ist das Helpful Content System eher ein Rahmen, der alle genutzten Nutzersignale und darauf basierenden Bewertungssysteme zusammenfasst. Deswegen würde ich es eher „User Satisfaction System“ nennen.

Was ist Deine Meinung? Lass uns diskutieren!

Der Beitrag Google Helpful Content: Was wirklich wichtig ist! erschien zuerst auf Aufgesang.

Information Gain: Wie wird er berechnet? Welche Faktoren sind entscheidend? 12 Jul 2024 3:30 AM (9 months ago)

Information Gain ist einer der spannendsten Rankingfaktoren für moderne Suchmaschinen und damit SEO. Vielen Erklärungen zum Information Gain mangelt es an technologischer Tiefe und es fehlen Ansätze zur Optimierung des Information Gain.

Dieser Artikel soll einen tiefen Überblick über das Konzept, die Berechnung und SEO-Ansätze zur Optimierung auf Information Gain geben. Auch die Verbindung zum Phrase Based Indexing wird erläutert.

Diese Insights zum Information Gain basieren auf grundlegenden Kenntnissen der interessantesten Google-Patente zum Thema Information Gain.

Was versteht man unter Information Gain im Zusammenhang mit Information Retrieval und Suchmaschinen?

Der Information Gain bzw. Informationsgewinn bezieht sich auf einen Score, der angibt, wie viele zusätzliche Informationen ein Dokument über die üblichen Informationen hinaus enthält, die in den von einem Nutzer zuvor angesehenen Dokumenten enthalten sind.

Dieser Wert hilft bei der Bestimmung, wie viele neue Informationen ein Dokument dem Benutzer im Vergleich zu dem, was der Benutzer bereits gesehen hat, bietet.

Bei diesen Methoden werden die Daten aus den Dokumenten auf ein maschinelles Lernmodell angewendet, um eine Bewertung des Informationsgewinns zu generieren, die dazu beiträgt, dem Benutzer Dokumente so zu präsentieren, dass diejenigen mit einer höheren Bewertung der neuen Informationen bevorzugt werden.

Beim Information Retrieval und bei Suchmaschinen wird der Informationsgewinn verwendet, um die Relevanz und Effektivität von Dokumenten oder Begriffen zu bewerten, um die Ungewissheit über den Informationsbedarf der Nutzer zu verringern. Er hilft bei der Einstufung von Dokumenten und bei der Verbesserung des Sucherlebnisses insgesamt.

Ein größerer Informationsgewinn deutet auf eine Gruppe oder Gruppen von Stichproben mit geringerer Entropie und damit auf eine geringere (negative) Überraschung hin.

Welche Rolle spielt die Entropie beim Information Gain?

Die Entropie spielt eine entscheidende Rolle beim Informationsgewinn im Rahmen des Entscheidungsbaumlernens. Genauer gesagt ist die Entropie ein Maß für die Unreinheit oder Unsicherheit in einem Datensatz. Bei der Erstellung von Entscheidungsbäumen wird der Informationsgewinn verwendet, um zu bestimmen, welches Attribut die Daten am besten in verschiedene Klassen unterteilt. Der Informationsgewinn wird als die Verringerung der Entropie berechnet, die sich aus der Partitionierung der Daten auf der Grundlage eines bestimmten Attributs ergibt.

- Entropie: Misst die Unreinheit oder Zufälligkeit in Daten.

- Hohe Entropie: Die Daten sind sehr gemischt und die Klassen sind ungleichmäßig verteilt.

- Geringe Entropie: Die Daten sind einheitlicher und die Klassen sind gleichmäßig verteilt.

- Die Werte der maximalen Entropie ändern sich mit der Anzahl der Klassen (z. B. 2 Klassen: maximale Entropie ist 1, 4 Klassen: maximale Entropie ist 2).

- Hohe Entropie: Die Daten sind sehr gemischt und die Klassen sind ungleichmäßig verteilt.